搜索技巧

海洋云增白

开源地图

AI 搜索答案

沙丘魔堡2

压缩机站

自由职业

policy

小团队

颈挂空调

Chumby

个人电脑

极端主义

团队

PostgreSQL

AI工具

证券

DirectX

DrawingPics

化学

KDE

披萨农场

多动症

植物学

分析化学

Three.js

大会

残疾人学校

初创

QB64

更多

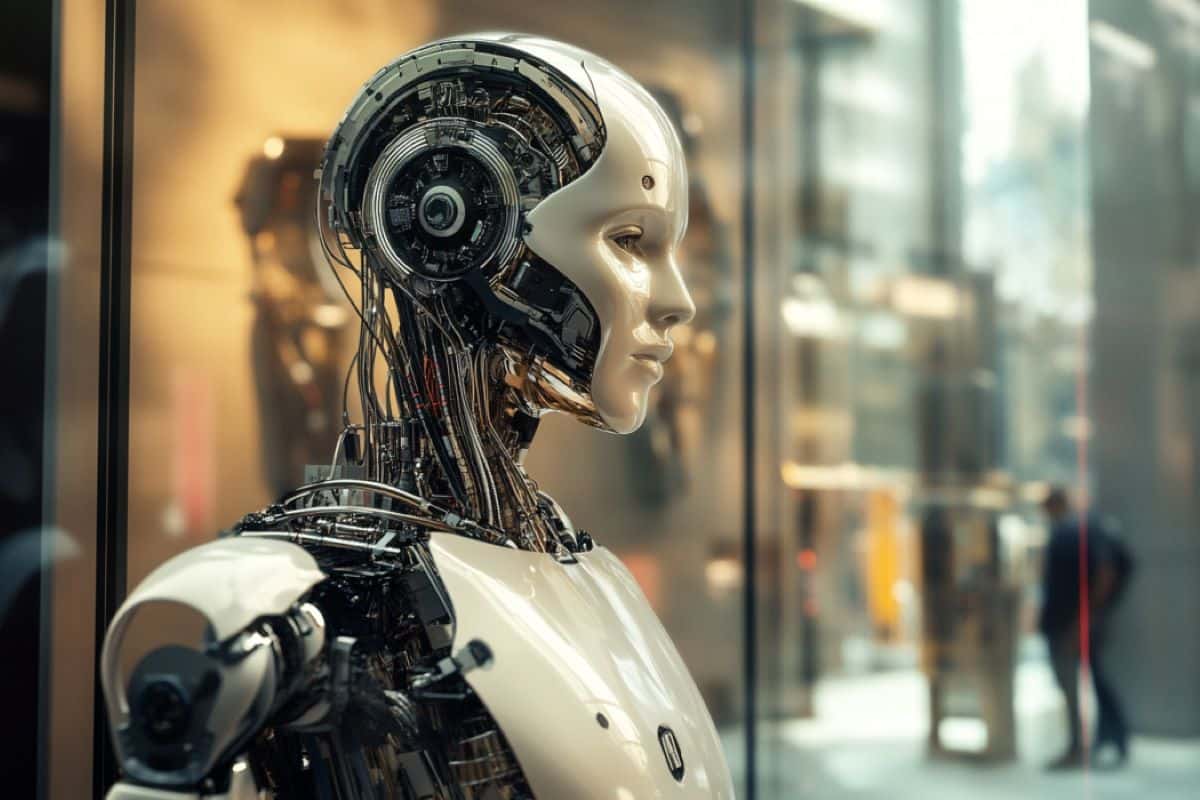

人工智能缺乏独立学习能力,不会构成生存威胁 (neurosciencenews.com)

最新研究表明,像ChatGPT这样的大型语言模型(LLM)无法独立学习或在没有明确指令的情况下习得新技能,这使得它们是可预测和可控的。 该研究消除了人们对这些模型发展出复杂推理能力的担忧,强调虽然大型语言模型可以生成复杂的语言,但它们不太可能构成生存威胁。 然而,人工智能的潜在滥用,如生成假新闻,仍然需要引起重视。

评论已经关闭!