Diseccionando un Transformer minimalista: Revelando el funcionamiento interno de los LLM con 10.000 parámetros

2025-09-04

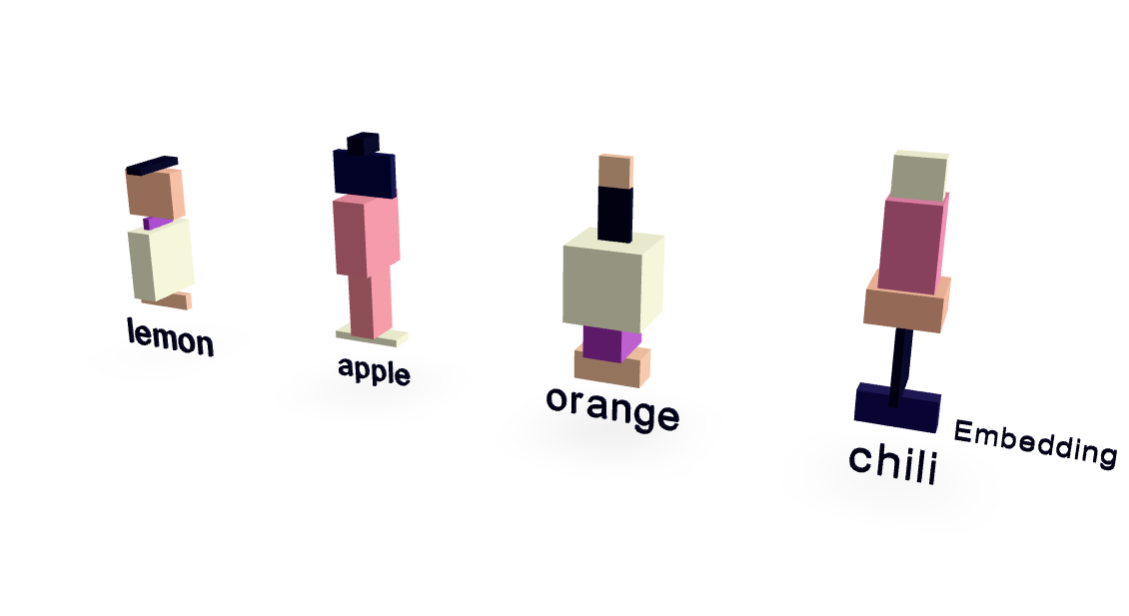

Este artículo presenta un modelo Transformer radicalmente simplificado con solo ~10.000 parámetros, ofreciendo una visión clara del funcionamiento interno de los modelos de lenguaje grandes (LLM). Utilizando un conjunto de datos mínimo centrado en las relaciones entre frutas y sabores, los autores logran un rendimiento sorprendentemente alto. Las visualizaciones revelan cómo funcionan los embeddings de palabras y el mecanismo de atención. Fundamentalmente, el modelo generaliza más allá de la memorización, prediciendo correctamente "chile" cuando se le pide con "Me gusta picante, así que me gusta", demostrando los principios básicos del funcionamiento de LLM de una manera muy accesible.

IA