أنثروبيك تُصلِح ثلاثة أخطاء في البنية التحتية تؤثر على كلاود

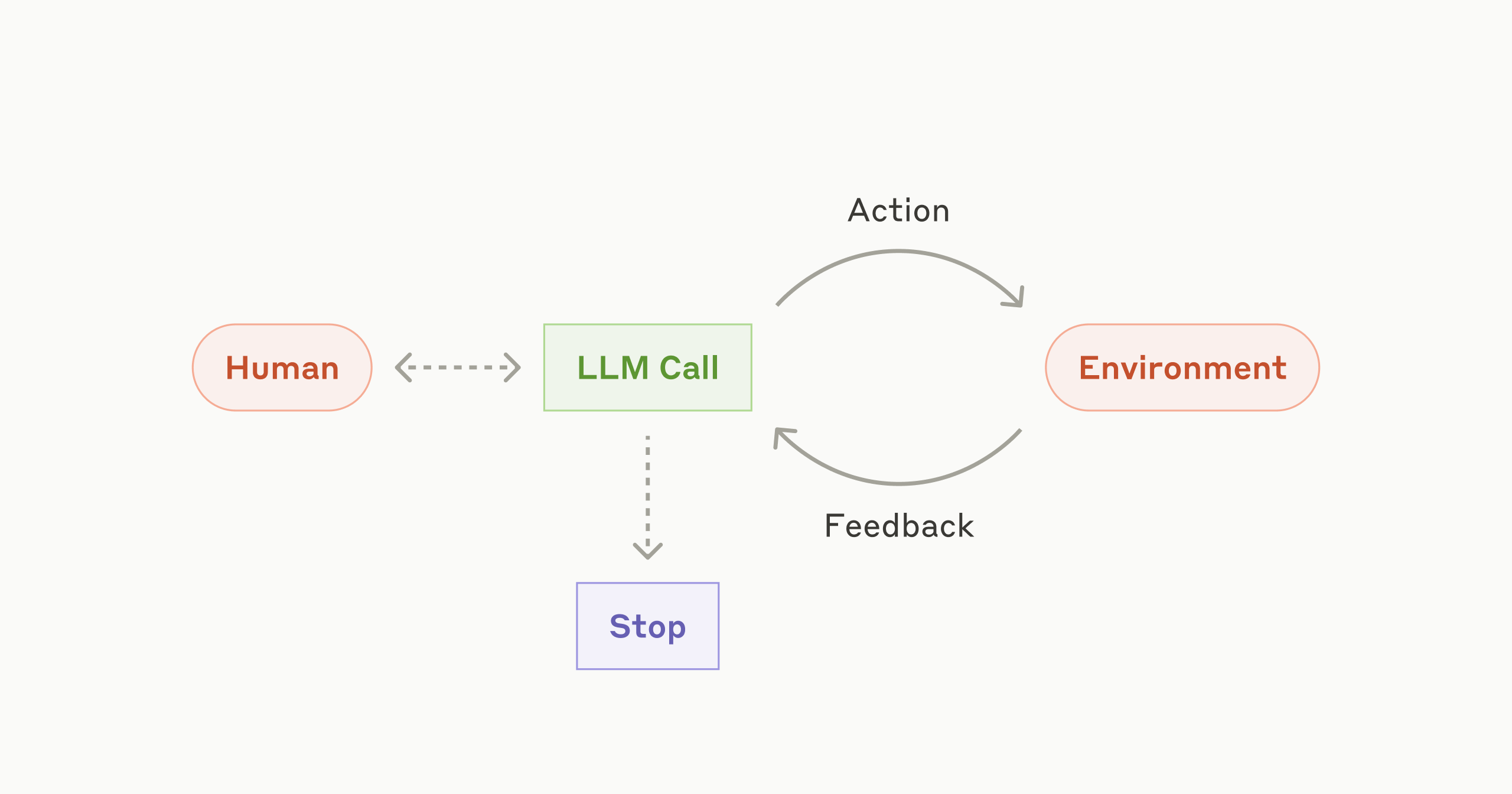

أقرت شركة أنثروبيك بأنه بين أغسطس وأوائل سبتمبر، تسببت ثلاثة أخطاء في البنية التحتية في تدهور جودة استجابات كلاود بشكل متقطع. هذه الأخطاء، التي تسببت في توجيه الطلبات بشكل خاطئ، وتلف الإخراج، وأخطاء في التجميع، أثرت على مجموعة فرعية من المستخدمين. وقد شرحت أنثروبيك أسباب هذه الأخطاء، وتشخيصها، وحلها، والتزمت بتحسين أدوات التقييم وإزالة الأخطاء لمنع تكرارها. ويبرز الحادث تعقيد وتحديات البنية التحتية لأنظمة نماذج اللغة الضخمة.

اقرأ المزيد