4枚の4090GPUで独自のLLMをローカルで訓練する

2024-12-28

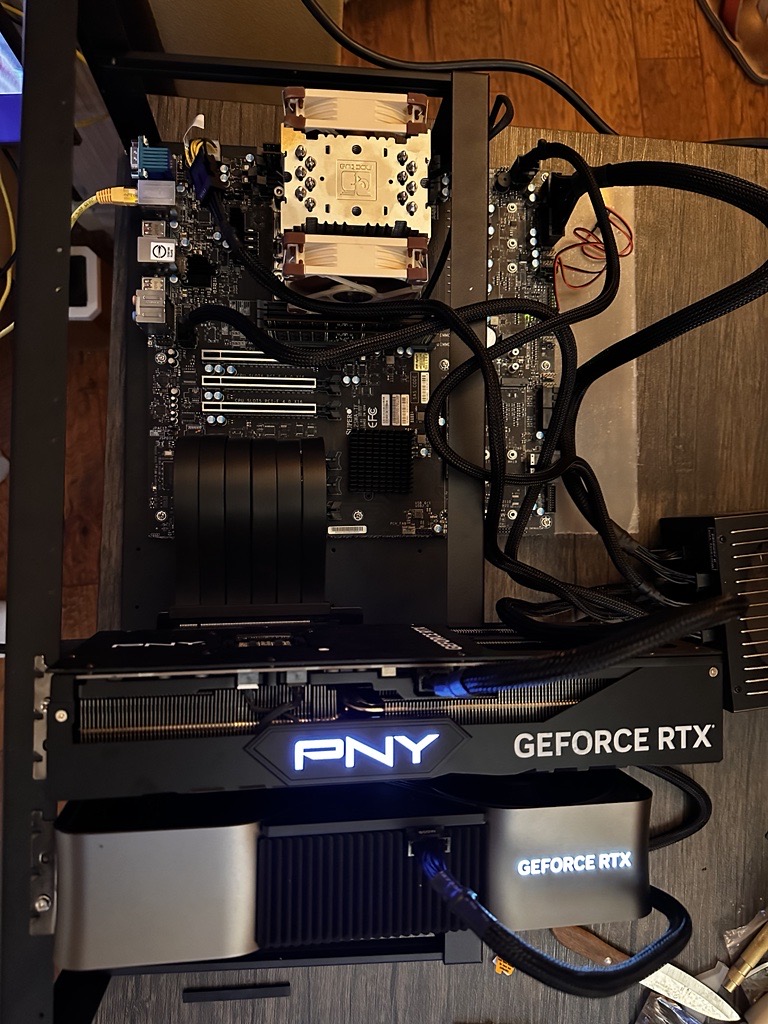

AI愛好家が、4枚のNVIDIA 4090 GPUを使用して大規模言語モデル(LLM)をローカルで訓練するための自作マシンを構築しました。費用は約12,000ドル。このセットアップでは、最大10億パラメーターのモデルを訓練できますが、約5億パラメーターのモデルで最適なパフォーマンスを発揮します。この記事では、ハードウェアの選択(マザーボード、CPU、RAM、GPU、ストレージ、電源、ケース、冷却システム)、組み立て手順、ソフトウェア構成(OS、ドライバー、フレームワーク、カスタムカーネル)、モデルの訓練、最適化、メンテナンスについて詳しく説明しています。George Hotzのカーネルパッチを使用して4xxx GPUのピアツーピア通信を有効にするなどのヒントも含まれています。ローカル訓練の利点を強調しながら、著者はいずれかのタスクに対するクラウドソリューションのコスト効率の高さにも言及しています。