4개의 4090 GPU로 자체 LLM을 로컬에서 학습시키기

2024-12-28

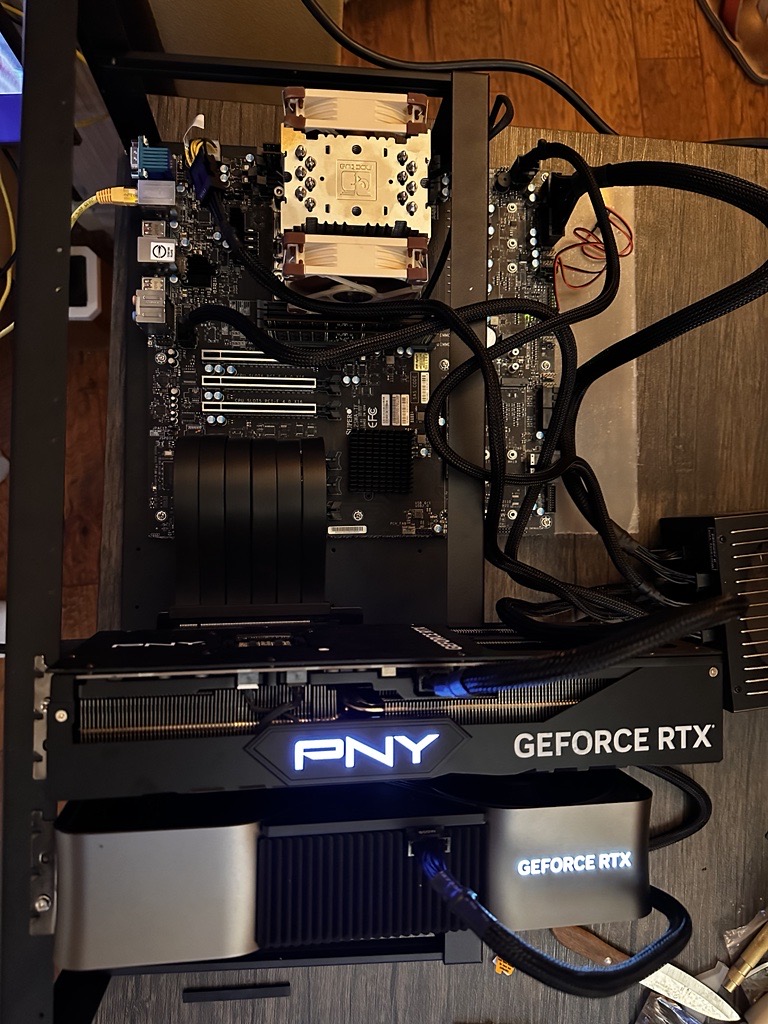

AI 애호가가 4개의 NVIDIA 4090 GPU를 사용하여 대규모 언어 모델(LLM)을 로컬에서 학습시키기 위한 맞춤형 시스템을 구축했습니다. 비용은 약 12,000달러였습니다. 이 시스템은 최대 10억 개의 매개변수를 가진 모델을 학습시킬 수 있지만, 약 5억 개의 매개변수를 가진 모델에서 최적의 성능을 발휘합니다. 이 글에서는 하드웨어 선택(마더보드, CPU, RAM, GPU, 스토리지, 전원 공급 장치, 케이스, 냉각 시스템), 조립 과정, 소프트웨어 구성(OS, 드라이버, 프레임워크, 사용자 지정 커널), 모델 학습, 최적화, 유지 관리에 대해 자세히 설명합니다. 4xxx GPU의 P2P 통신을 활성화하기 위해 George Hotz의 커널 패치를 사용하는 팁도 포함되어 있습니다. 로컬 학습의 장점을 강조하면서, 저자는 특정 작업에 대한 클라우드 솔루션의 비용 효율성도 언급합니다.