LLMをローカルで実行する:開発者向けガイド

2024-12-29

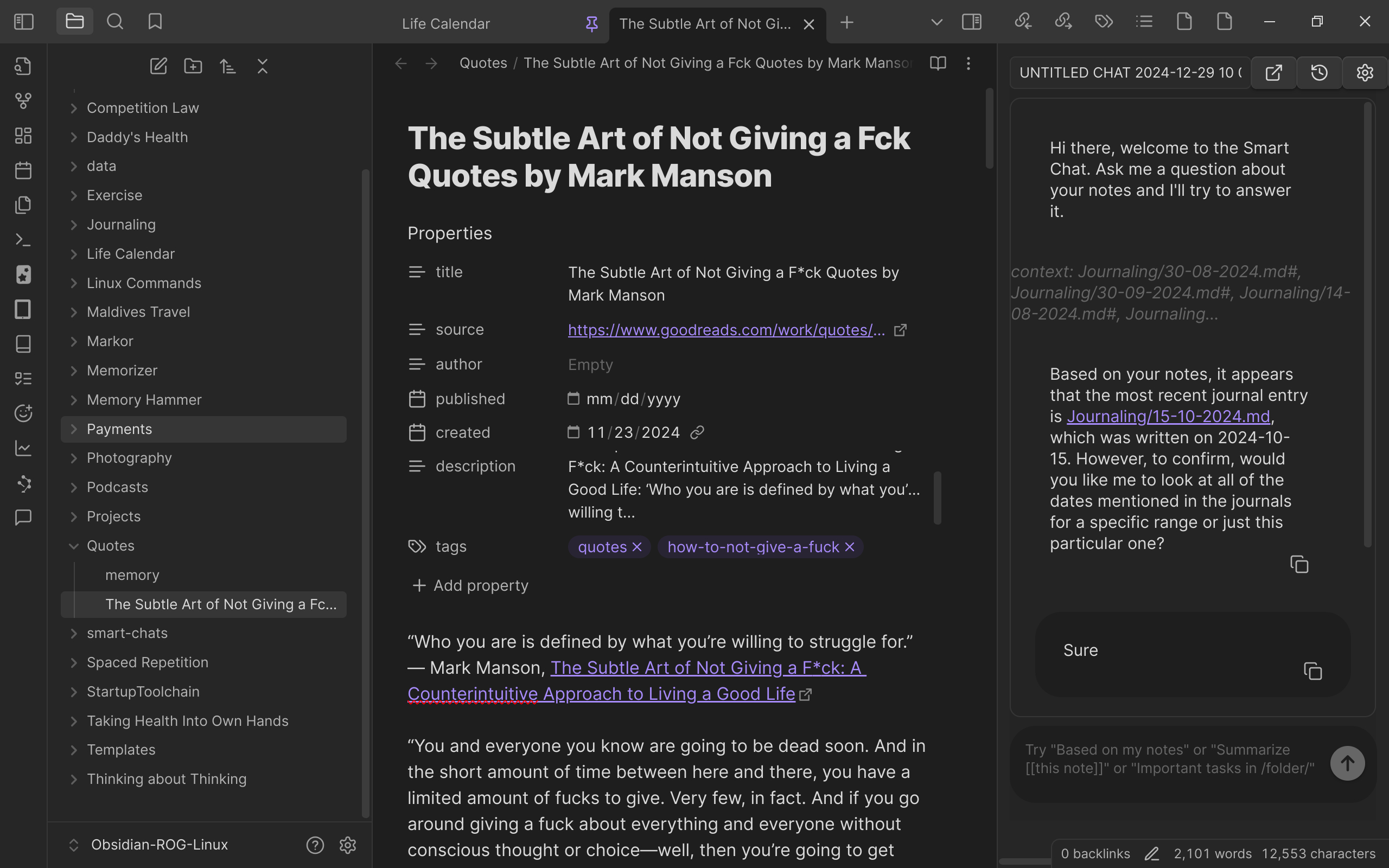

開発者が、個人用コンピューターでLLM(大規模言語モデル)を実行した経験を共有しています。高性能マシン(i9 CPU、4090 GPU、RAM 96GB)と、Ollama、Open WebUIなどのオープンソースツールを使用して、コード補完やノート検索などのタスクのために複数のLLMを正常に実行しました。この記事では、使用したハードウェア、ソフトウェア、モデル、更新方法について詳しく説明し、LLMをローカルで実行することによるデータセキュリティと低遅延の利点を強調しています。

開発

ローカル実行