최소주의 Transformer 해부: 1만 개의 매개변수로 LLM의 내부 작동 방식 밝히기

2025-09-04

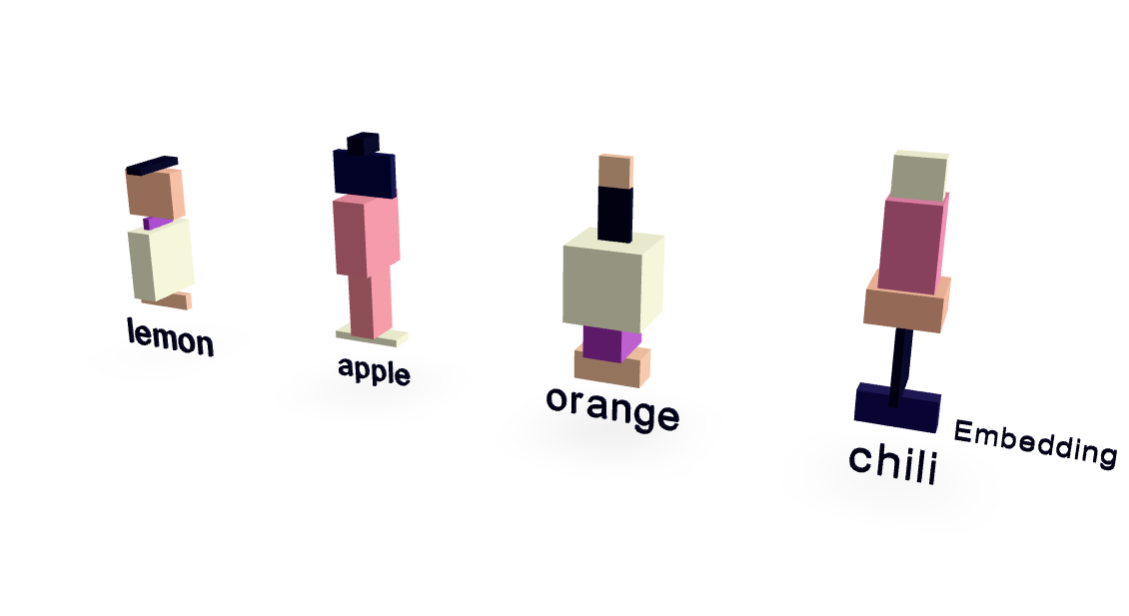

이 논문은 약 1만 개의 매개변수만 사용하는 극도로 단순화된 Transformer 모델을 제시하여 대규모 언어 모델(LLM)의 내부 작동 방식을 명확하게 보여줍니다. 과일과 맛의 관계에 초점을 맞춘 최소한의 데이터 세트를 사용하여 놀라울 정도로 높은 성능을 달성합니다. 시각화를 통해 단어 임베딩과 어텐션 메커니즘의 기능이 드러납니다. 중요한 점은 이 모델이 단순 암기 이상으로 일반화하여, "매운 것을 좋아하므로 좋아해"라는 프롬프트에 대해 "고추"를 정확하게 예측함으로써 LLM 작동의 핵심 원리를 매우 쉽게 보여줍니다.

AI