DeepSeek v3: تحسينات كبيرة في بنية Transformer

2025-01-28

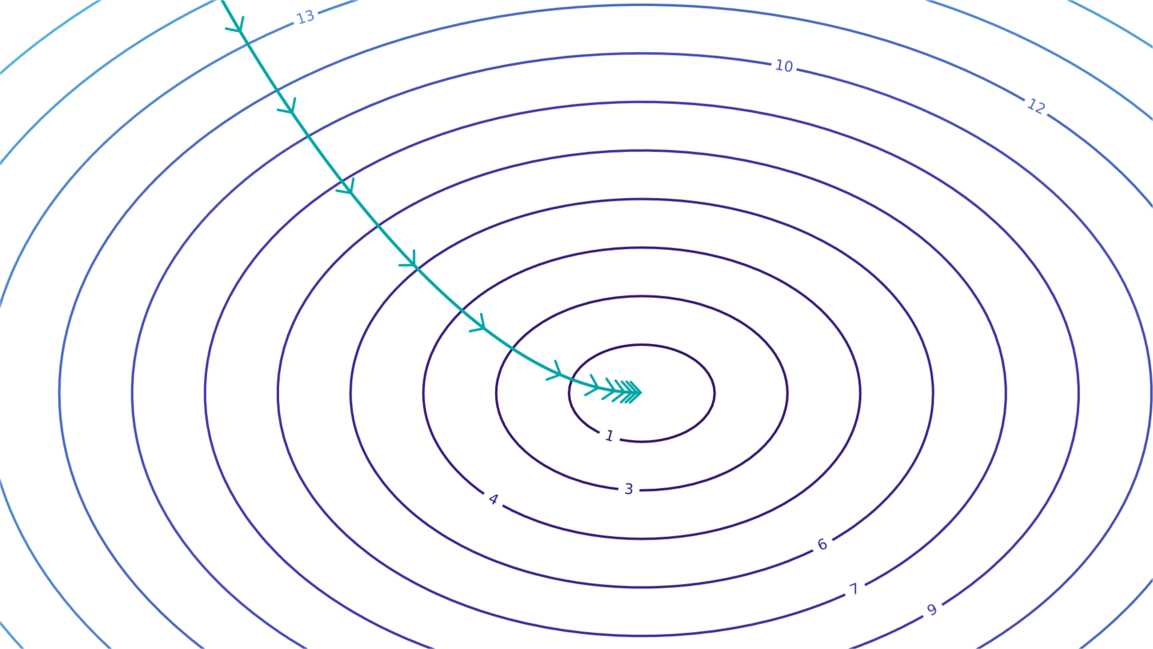

يحقق DeepSeek v3 أداءً متطورًا في المعايير مع كمية حسابية أقل بكثير من النماذج المماثلة. ويعود ذلك إلى تحسينات معمارية رئيسية: تقلل تقنية الانتباه الكامن متعدد الرؤوس (MLA) حجم ذاكرة التخزين المؤقت KV بشكل كبير دون التضحية بجودة النموذج؛ ويعالج نموذج الخبراء المختلط (MoE) المحسّن مشكلة انهيار التوجيه من خلال موازنة التحميل بدون خسارة مساعدة وخبراء مشتركين؛ كما تزيد التنبؤات متعددة الرموز من كفاءة التدريب وسرعة الاستنتاج. تُظهر هذه التحسينات فهمًا عميقًا لعمارة Transformer وتُشير إلى الطريق المُستقبلي لأنماط اللغات الكبيرة.

(epoch.ai)

الذكاء الاصطناعي