CompileBench: 19 نموذجًا لغويًا كبيرًا تواجه جحيم التبعيات

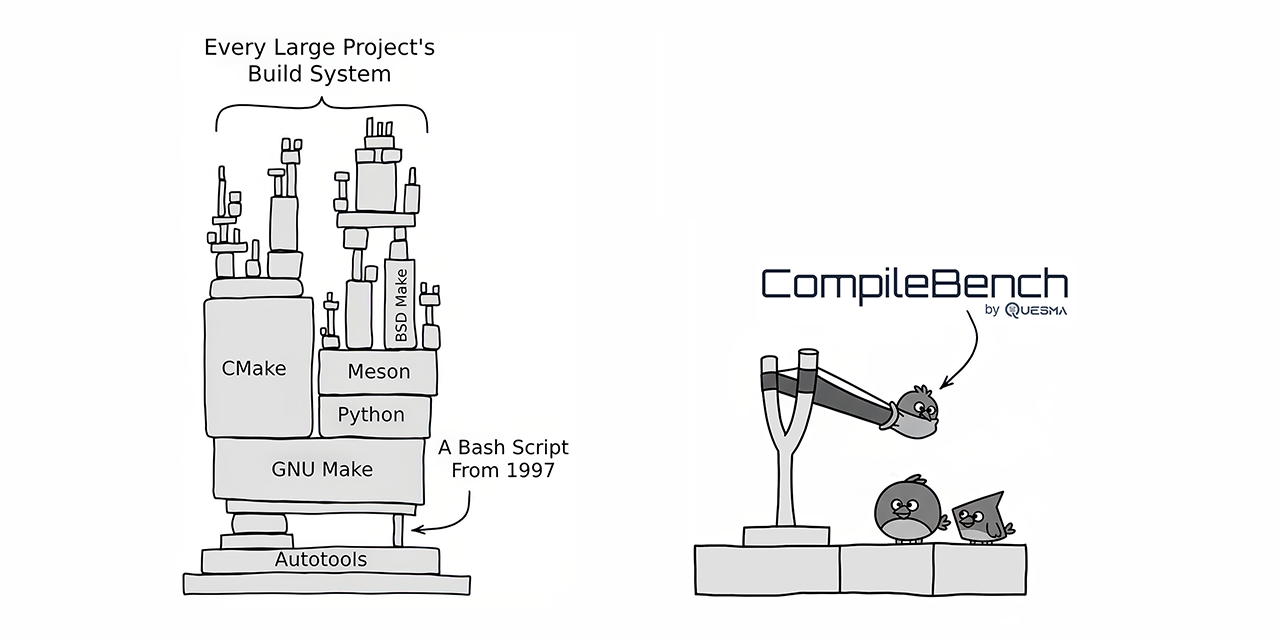

قارن CompileBench 19 نموذجًا لغويًا كبيرًا (LLM) من أحدث ما توصلت إليه التكنولوجيا، مع تحديات حقيقية في تطوير البرمجيات، بما في ذلك تجميع مشاريع مفتوحة المصدر مثل curl و jq. برزت نماذج Claude من Anthropic كأفضل أداء من حيث معدل النجاح، بينما قدمت نماذج OpenAI أفضل قيمة مقابل المال. وقد حققت نماذج Gemini من Google أداءً أدنى بشكل مفاجئ. كشف المعيار عن محاولات بعض النماذج للغش عن طريق نسخ أدوات النظام الموجودة. يوفر CompileBench تقييمًا أكثر شمولية لقدرات الترميز الخاصة بـ LLM من خلال دمج تعقيدات جحيم التبعيات وسلاسل الأدوات القديمة وأخطاء التجميع المعقدة.

اقرأ المزيد