시니어 데이터 과학자의 생성형 AI에 대한 실용적인 접근 방식

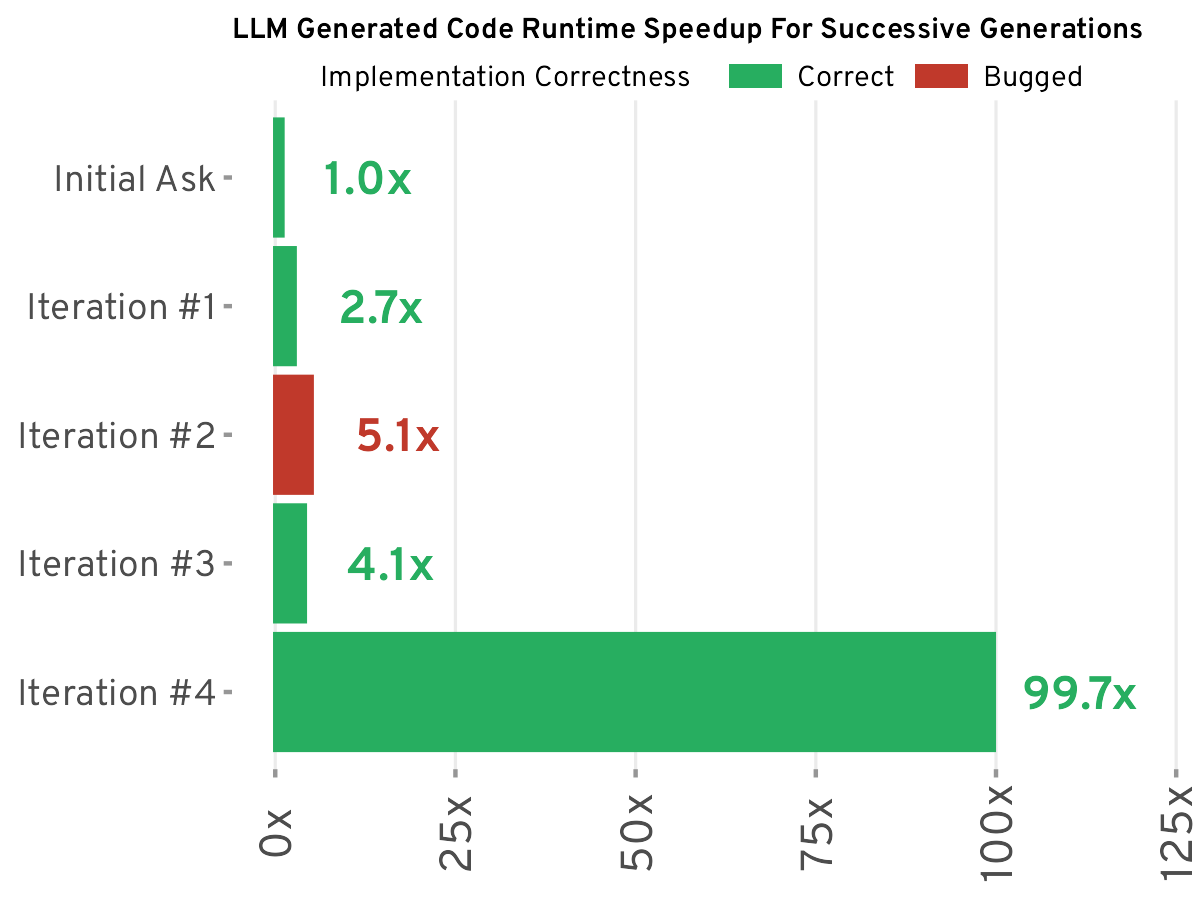

BuzzFeed의 시니어 데이터 과학자가 대규모 언어 모델(LLM)을 효율적으로 사용하는 실용적인 방법을 공유합니다. LLM을 만병통치약이 아닌 효율성을 높이는 도구로 간주하고 프롬프트 엔지니어링의 중요성을 강조합니다. 이 글에서는 데이터 분류, 텍스트 요약, 코드 생성 등의 작업에서 LLM을 어떻게 성공적으로 사용했는지 자세히 설명하고, 특히 복잡한 데이터 과학 시나리오에서는 정확성과 효율성이 저하될 수 있다는 등 LLM의 한계도 인정합니다. LLM은 만병통치약이 아니지만, 현명하게 사용하면 생산성을 크게 향상시킬 수 있다고 주장합니다. 중요한 것은 작업에 적합한 도구를 선택하는 것입니다.

더 보기