大型语言模型量化的可视化指南

2024-07-30

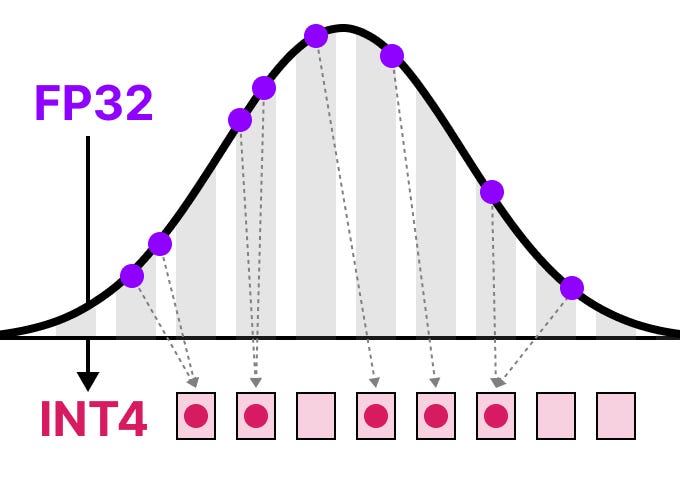

这篇博客文章深入探讨了大型语言模型 (LLM) 中的量化领域,量化是一种通过以较低位宽表示数值来压缩模型大小的技术。文章首先解释了数值表示和内存限制,然后介绍了常见的量化数据类型,包括 FP16、BF16 和 INT8。文章详细介绍了对称和非对称量化方法,包括 Absmax 和零点量化,以及范围映射、剪裁和校准等概念。此外,文章还探讨了训练后量化 (PTQ) 和量化感知训练 (QAT) 技术,重点介绍了动态和静态量化。文章还深入研究了 4 位量化,包括 GPTQ 和 GGUF 等方法,并探讨了 1 位 LLM 和 BitNet 的出现,分析了权重和激活量化以及使用三元表示的好处。