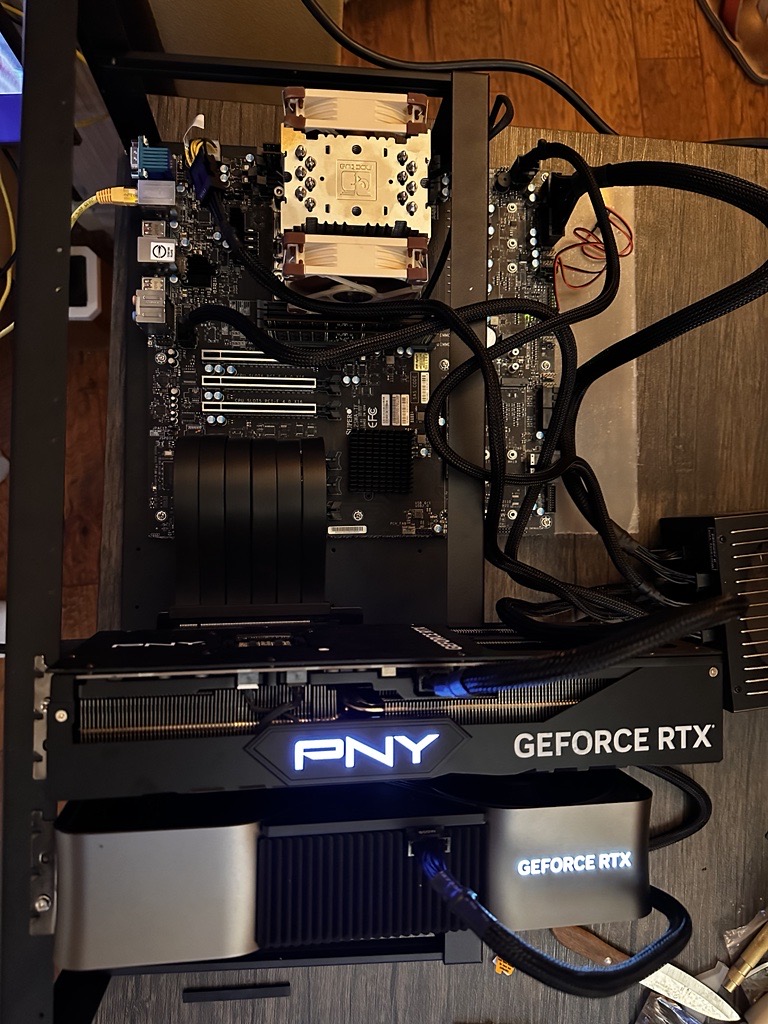

4 GPUs 4090: Treinando seus próprios LLMs localmente

Um entusiasta de IA construiu um equipamento local para treinar modelos de linguagem amplos (LLMs) usando quatro GPUs NVIDIA 4090, custando cerca de US$ 12.000. Essa configuração pode treinar modelos de até 1 bilhão de parâmetros, embora tenha um desempenho ideal com cerca de 500 milhões. O artigo detalha a seleção de hardware (placa-mãe, CPU, RAM, GPUs, armazenamento, PSU, gabinete, resfriamento), o processo de montagem, a configuração de software (SO, drivers, frameworks, kernel personalizado), o treinamento do modelo, otimização e manutenção. As dicas incluem o uso do patch de kernel de George Hotz para comunicação P2P em GPUs 4xxx. Embora destaque os benefícios do treinamento local, o autor reconhece a relação custo-benefício das soluções em nuvem para algumas tarefas.

Leia mais