Débloquer les données tabulaires pour les LLM : une approche de distillation mécanique

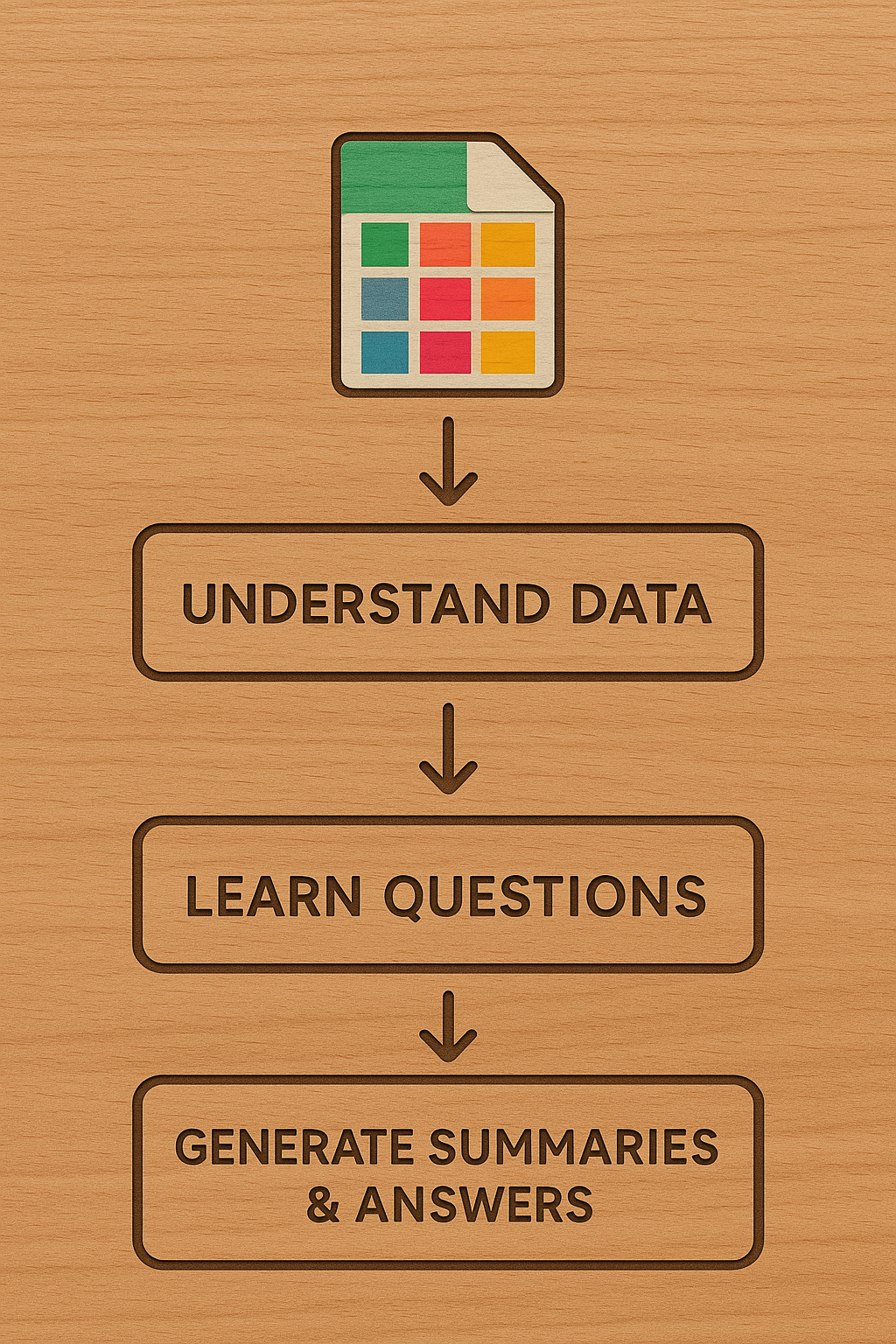

Les grands modèles de langage (LLM) excellent dans le traitement du texte et des images, mais ont du mal avec les données tabulaires. Actuellement, les LLM s'appuient principalement sur des résumés statistiques publiés, sans exploiter pleinement les connaissances contenues dans les ensembles de données tabulaires, telles que les données d'enquête. Cet article propose une nouvelle approche utilisant des techniques de distillation mécanique pour créer des résumés univariés, bivariés et multivariés. Cela est complété en demandant au LLM de suggérer des questions pertinentes et d'apprendre à partir des données. Le pipeline en trois étapes implique de comprendre la structure des données, d'identifier les types de questions et de générer des résumés mécaniques et des visualisations. Les auteurs suggèrent que cette approche peut améliorer les systèmes de génération augmentée par la récupération (RAG) et compléter les 'connaissances du monde' potentiellement biaisées, en recommandant de commencer par les référentiels d'articles scientifiques (comme Harvard Dataverse) et les données administratives pour la validation.