Ajustement fin des LLMs : injection de connaissances ou écrasement destructeur ?

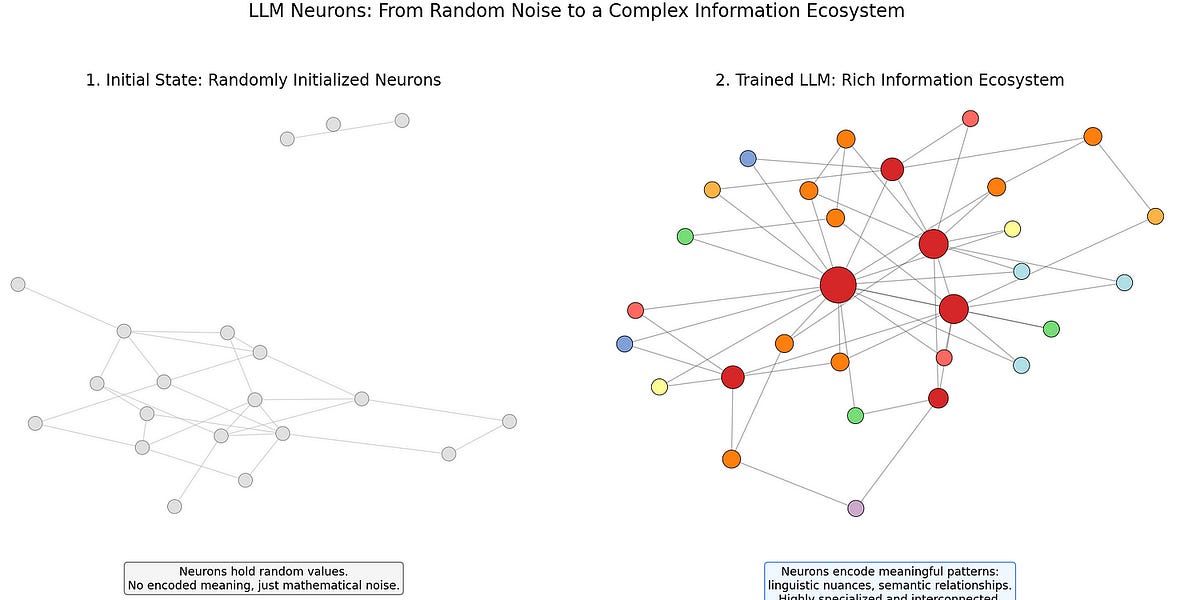

Cet article révèle les limites de l’ajustement fin des grands modèles de langage (LLM). L’auteur soutient que, pour les LLM avancés, l’ajustement fin n’est pas une simple injection de connaissances, mais peut être destructeur, en écrasant les structures de connaissances existantes. L’article examine le fonctionnement des réseaux neuronaux et explique comment l’ajustement fin peut entraîner la perte d’informations cruciales au sein des neurones existants, entraînant des conséquences imprévues. L’auteur préconise des solutions modulaires telles que la génération augmentée par la récupération (RAG), les modules adaptateurs et l’ingénierie des invites pour injecter plus efficacement de nouvelles informations, sans endommager l’architecture générale du modèle.