Exécuter des LLMs localement : guide pour les développeurs

2024-12-29

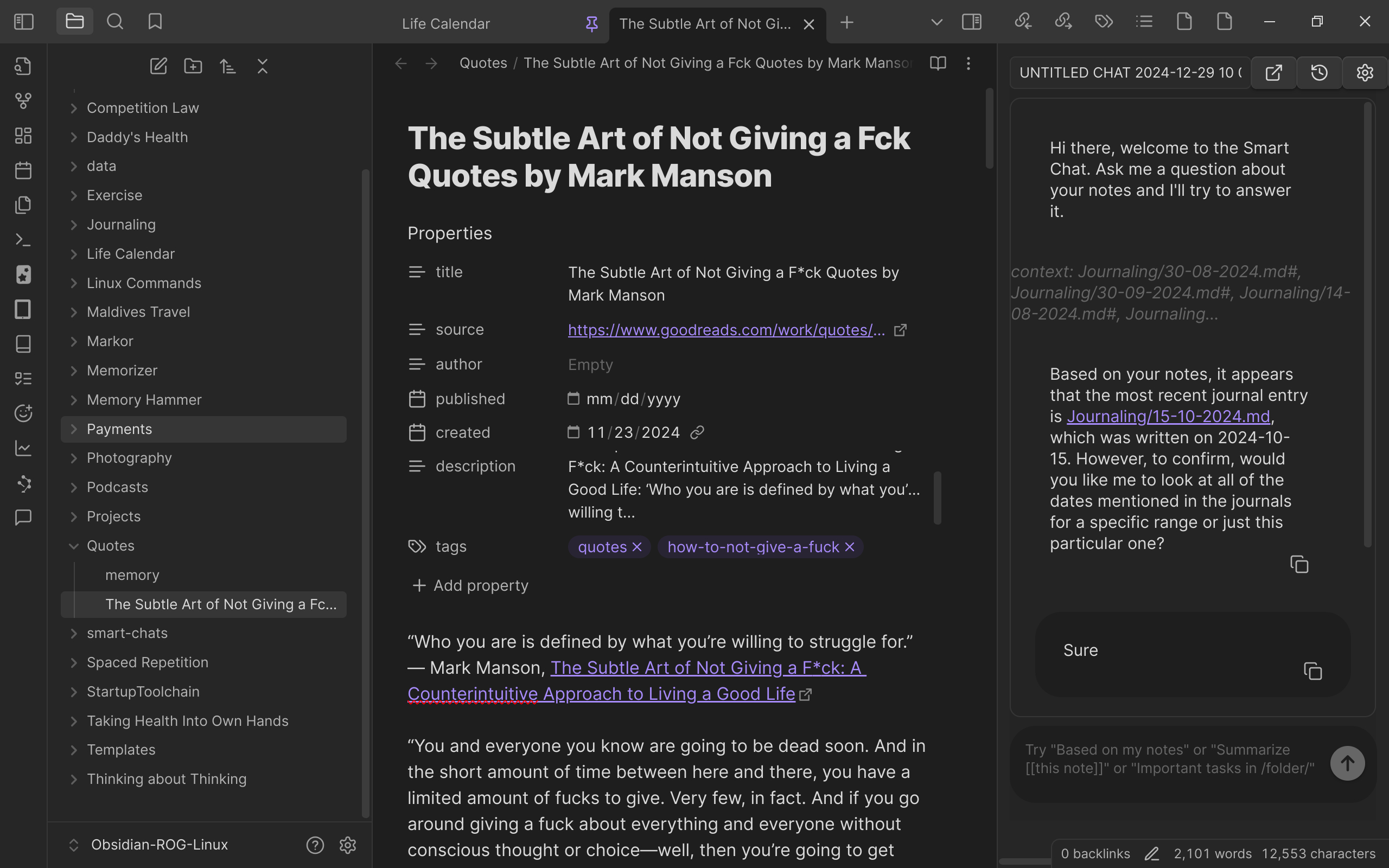

Un développeur partage son expérience d’exécution de grands modèles de langage (LLM) sur un ordinateur personnel. À l’aide d’une machine haut de gamme (processeur i9, GPU 4090, 96 Go de RAM), ainsi que d’outils open source tels qu’Ollama et Open WebUI, il a exécuté avec succès plusieurs LLM pour des tâches telles que la complétion de code et les requêtes de notes. L’article détaille le matériel, les logiciels, les modèles utilisés et les méthodes de mise à jour, en soulignant les avantages en matière de sécurité des données et de faible latence de l’exécution locale des LLM.