Des informations obsolètes se cachent dans les LLMs : comment les probabilités de jetons créent des incohérences logiques

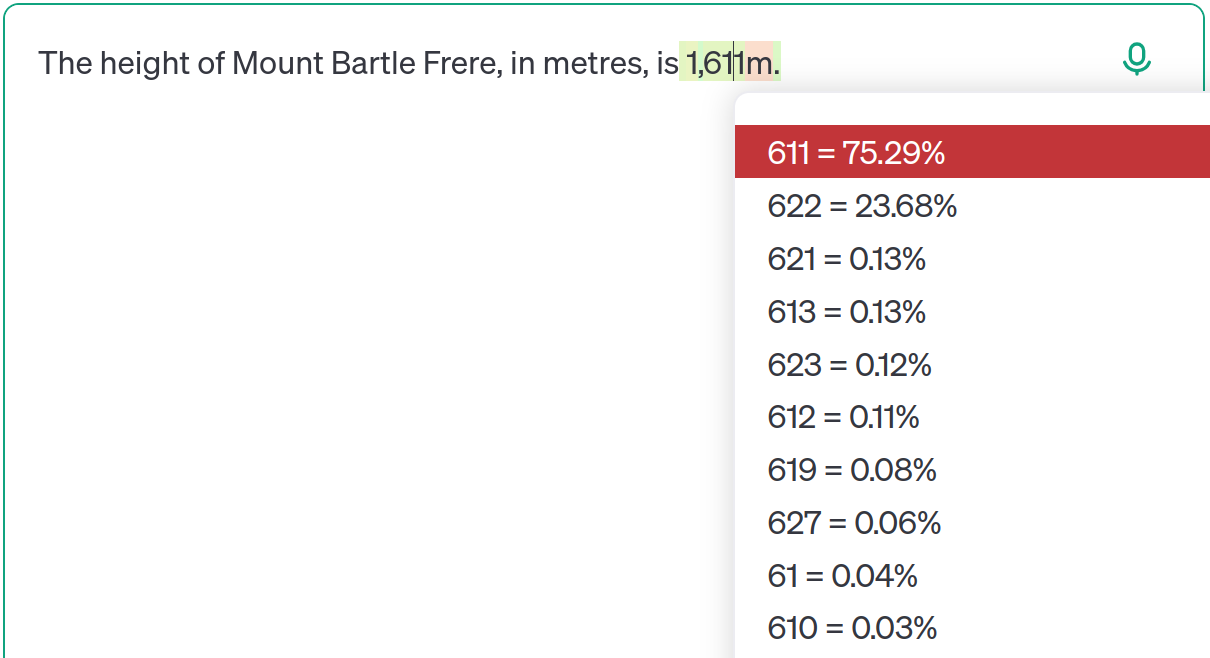

Les grands modèles de langage (LLM) tels que ChatGPT, entraînés sur des ensembles de données massifs d’Internet, sont souvent confrontés à des informations contradictoires ou obsolètes. Cet article utilise la hauteur du mont Bartle Frere comme étude de cas, montrant comment les LLM ne privilégient pas toujours les informations les plus récentes. Au lieu de cela, ils effectuent des prédictions basées sur des distributions de probabilité apprises à partir de leurs données d’entraînement. Même les modèles avancés tels que GPT-4o peuvent produire des informations obsolètes en fonction de variations subtiles de l’invite. Il ne s’agit pas d’une simple « hallucination », mais d’une conséquence du fait que le modèle apprend de multiples possibilités et ajuste les probabilités en fonction du contexte. L’auteur souligne l’importance de comprendre les limites des LLM, d’éviter une dépendance excessive et de mettre l’accent sur la transparence.