La percée IA de DeepSeek : contournement de CUDA pour une efficacité multipliée par 10

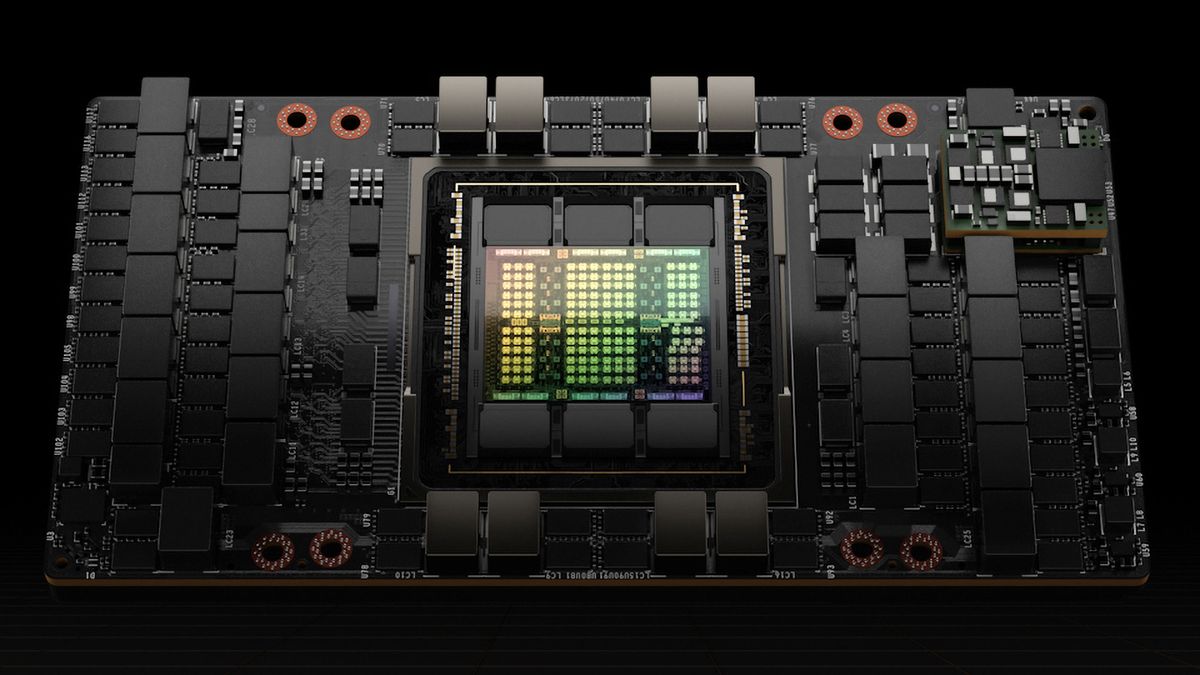

DeepSeek a réalisé une amélioration de 10 fois de l'efficacité de l'entraînement des modèles d'IA en contournant le CUDA standard de l'industrie et en utilisant à la place le langage de programmation PTX de Nvidia. Utilisant 2 048 GPU Nvidia H800, ils ont entraîné un modèle de langage MoE de 671 milliards de paramètres en seulement deux mois. Cette percée provient d'optimisations méticuleuses du PTX de Nvidia, incluant la reconfiguration des ressources GPU et la mise en œuvre d'algorithmes de pipeline avancés. Bien que cette approche ait des coûts de maintenance élevés, la réduction drastique des coûts d'entraînement a provoqué des ondes de choc sur le marché, entraînant même une baisse significative de la capitalisation boursière de Nvidia.