FastVLM d'Apple : Un modèle de langage visuel ultra-rapide

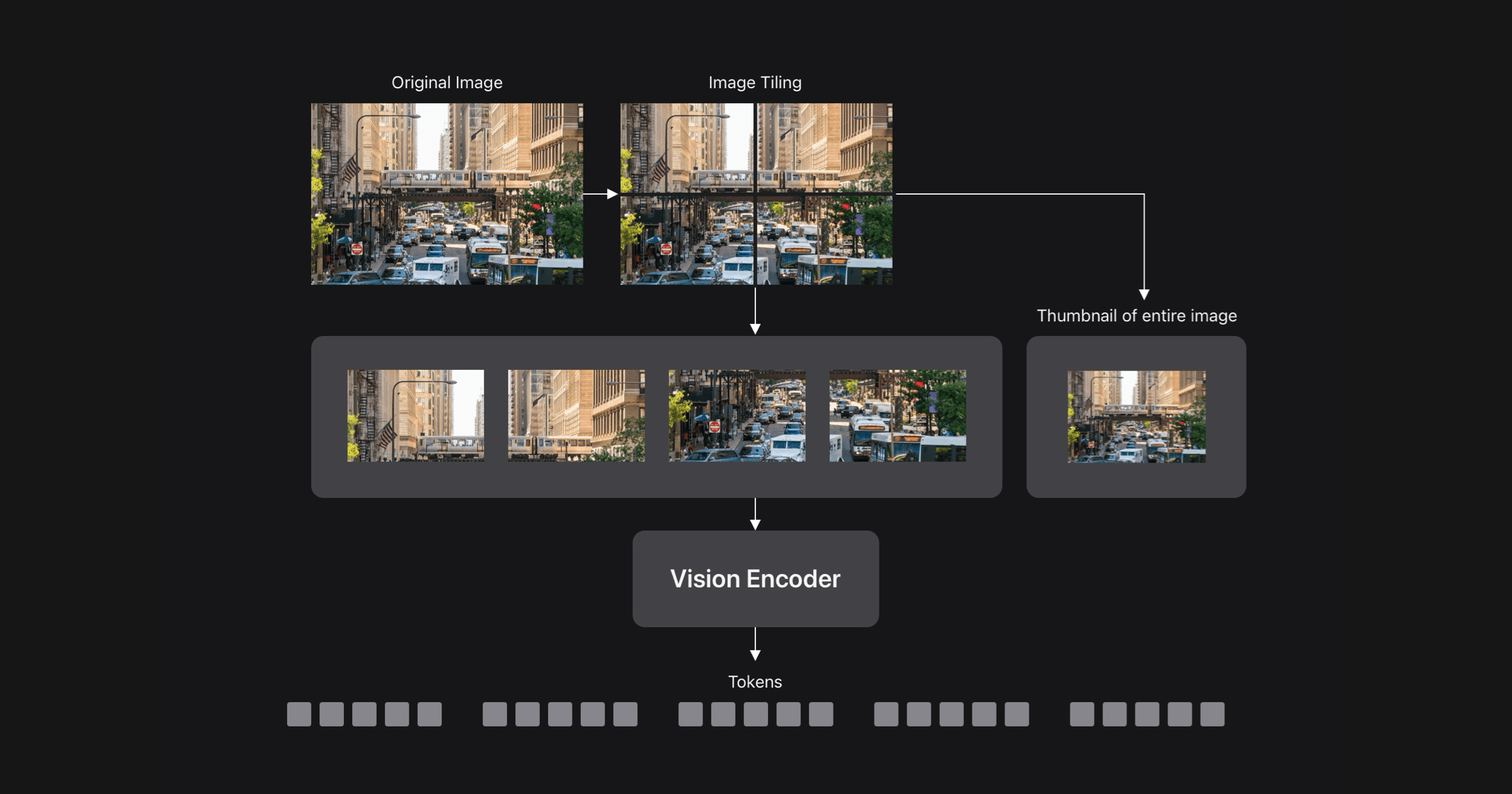

Les chercheurs d'Apple ML ont dévoilé FastVLM, un nouveau modèle de langage visuel (VLM), au CVPR 2025. En s'attaquant au compromis entre précision et efficacité inhérent aux VLM, FastVLM utilise un encodeur de vision à architecture hybride, FastViTHD, conçu pour les images haute résolution. Cela se traduit par un VLM significativement plus rapide et plus précis que les modèles comparables, permettant des applications en temps réel sur les appareils et une IA préservant la vie privée. FastViTHD génère moins de jetons visuels, mais de meilleure qualité, accélérant le préremplissage du LLM. Une application de démonstration iOS/macOS met en évidence les capacités de FastVLM sur les appareils.

Lire plus