効率的なファインチューニング:LoRAの詳細解説(パート1)

2024-12-25

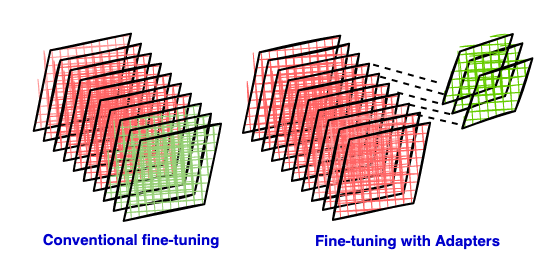

大規模言語モデルのファインチューニングは通常、相当な計算資源を必要とします。この記事では、パラメータ効率の高いファインチューニング手法であるLoRAを紹介します。LoRAは、事前学習済みモデルに低ランク行列をアダプターとして挿入することで、トレーニングに必要なパラメータ数を大幅に削減し、計算コストとストレージコストを削減します。このパート1では、LoRAの背後にある原理、従来のファインチューニングの欠点、パラメータ効率の高い手法の利点、低ランク近似の数学的基礎について説明します。続くパートでは、LoRAの具体的な実装と適用について詳しく説明します。