大型语言模型的推理能力常被高估

2024-07-12

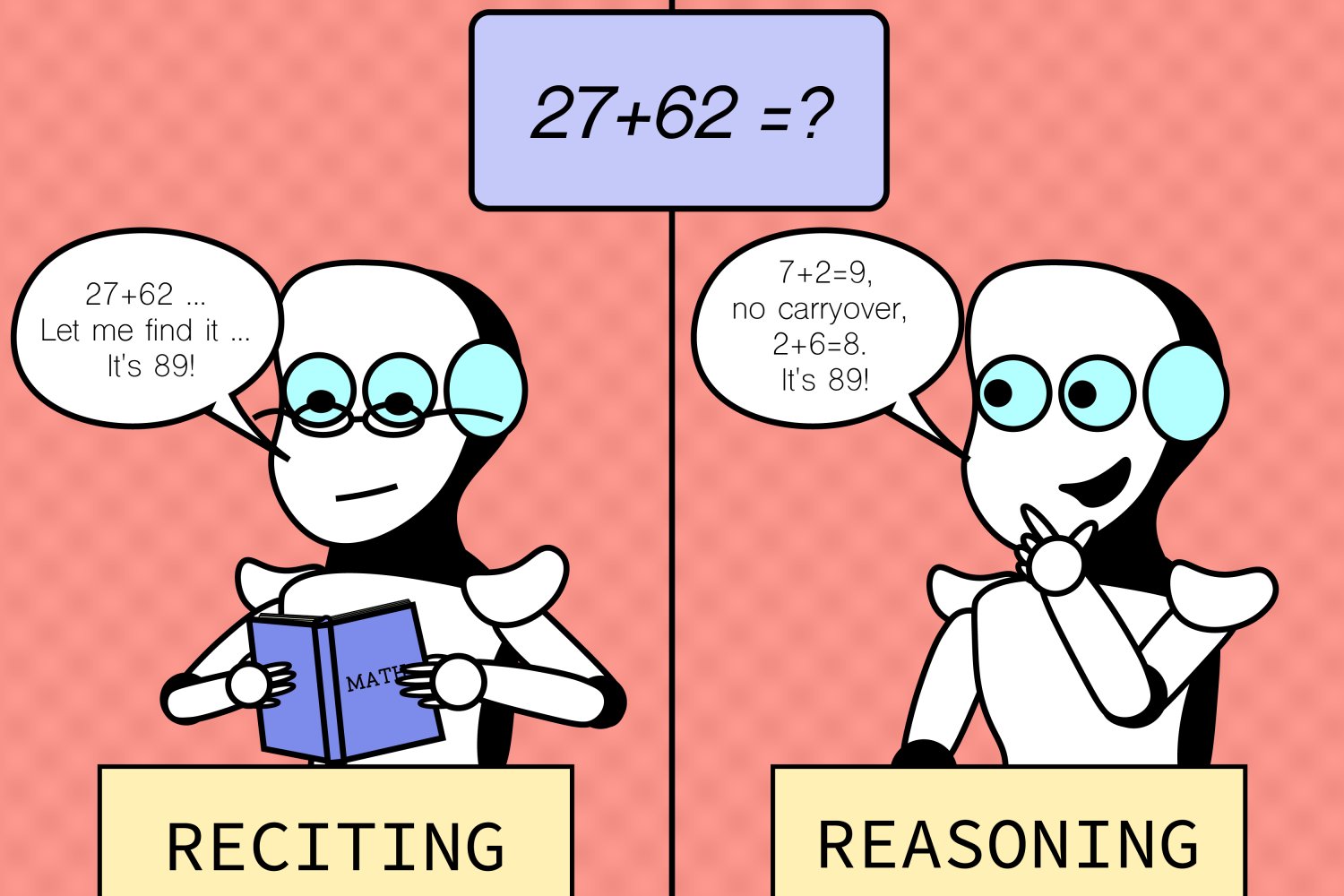

麻省理工学院计算机科学与人工智能实验室(CSAIL)的研究人员发现,大型语言模型(LLM)的推理能力经常被高估。研究表明,LLM 擅长处理熟悉的任务,但在面对不熟悉的任务时表现不佳,这表明它们缺乏泛化能力。研究人员通过修改现有任务,例如将算术问题从常见的十进制改为其他进制,以及改变国际象棋中棋子的初始位置,来测试LLM 在反事实场景下的表现。结果显示,LLM 在这些场景下的表现远不如预期,甚至无法超越随机猜测。

51

未分类