Entropie: Die Enträtselung des universellen Zeitpfeils

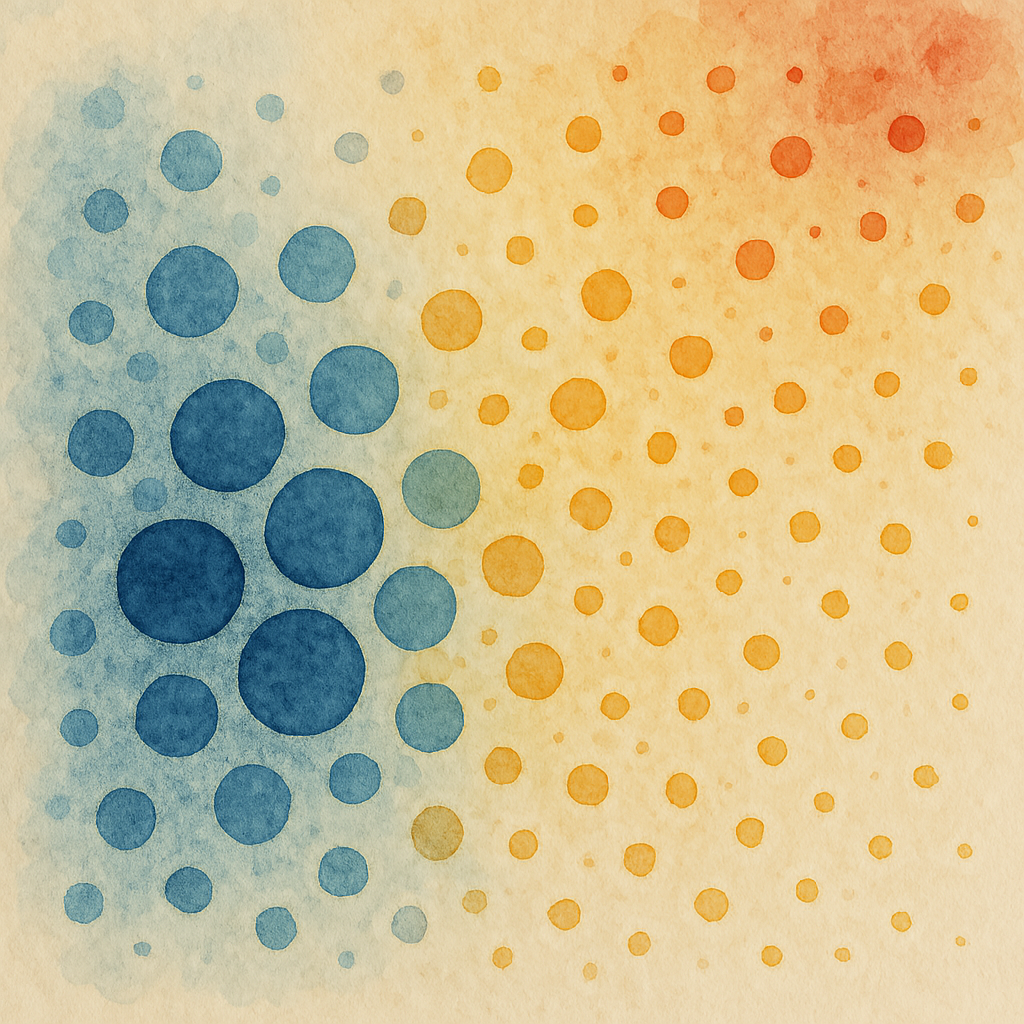

Dieser Artikel bietet eine leicht verständliche Erklärung des Entropiekonzepts. Entropie ist nicht einfach „Unordnung“, sondern ein Maß für die Unsicherheit innerhalb eines Systems. Aus informationstheoretischer Sicht repräsentiert die Entropie die Anzahl der Bits, die benötigt werden, um den Zustand eines Systems zu kommunizieren; aus der statistischen Mechanik ergibt sich ein Zusammenhang zur Anzahl der Mikrozustände, die einem gegebenen Makrozustand entsprechen. Am Beispiel von Kugeln in einer Box wird der Einfluss von Makrozuständen, Mikrozuständen und grober Körnung auf die Entropie veranschaulicht und erklärt, warum die Zeit eine Richtung hat: Das Universum begann in einem Zustand niedriger Entropie, und Systeme entwickeln sich zu Zuständen höherer Entropie, nicht weil die physikalischen Gesetze irreversibel sind, sondern weil Zustände höherer Entropie viel wahrscheinlicher sind. Der Artikel behandelt auch scheinbar entropieverletzende Phänomene wie die Trennung von Öl und Wasser und zeigt, dass die Entropie tatsächlich zunimmt, wenn alle Attribute des Systems berücksichtigt werden.