改进的跨编码器揭示大型语言模型微调的秘密

2025-03-23

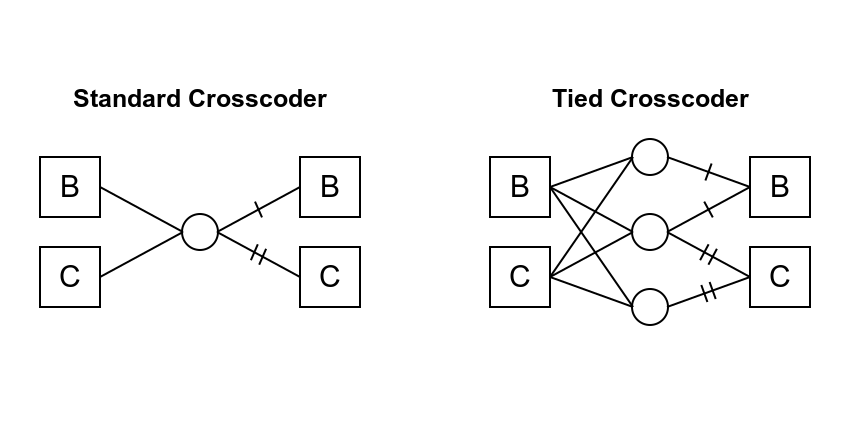

研究人员提出了一种名为“绑定跨编码器”的新方法,用于比较大型语言模型(LLM)的基础模型和微调后的聊天模型。与传统的跨编码器不同,绑定跨编码器允许相同的潜在因素在不同时间点为基础模型和聊天模型激发,从而更有效地识别出聊天模型中新增的特性。实验结果表明,这种方法能够更清晰地解释聊天模型行为是如何从基础模型的功能中产生的,并得到更单义的潜在因素。这项研究为理解LLM的微调过程提供了新的视角,并为今后的模型改进提供了方向。

AI

跨编码器