Distillation des connaissances : comment les petits modèles d’IA peuvent défier les géants

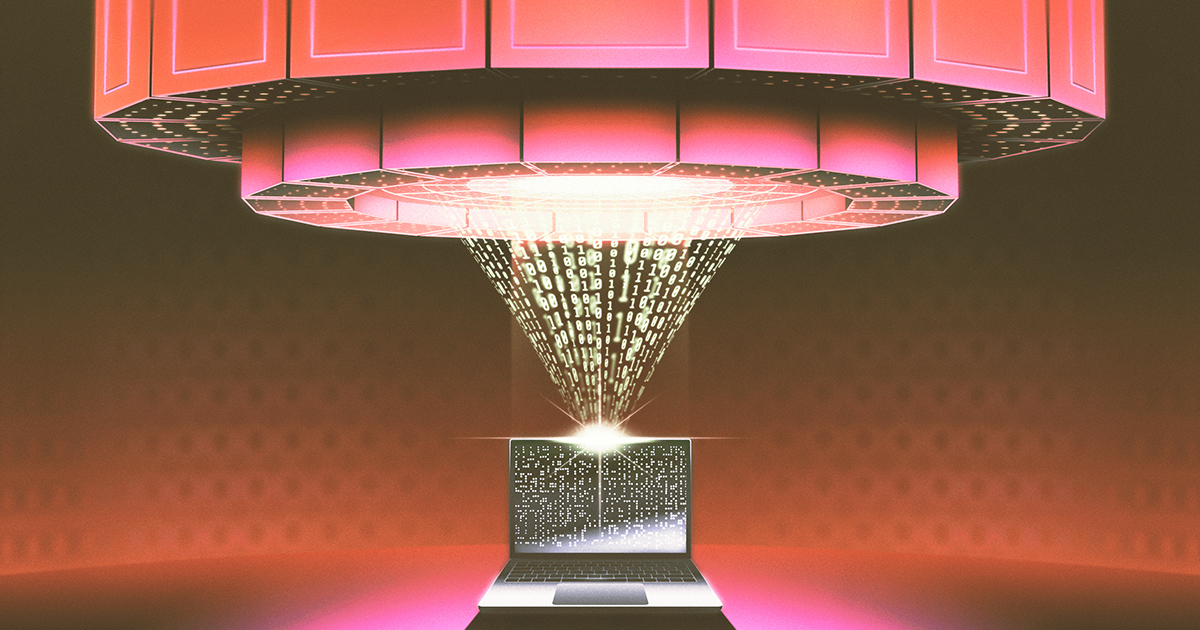

Le chatbot R1 de la société chinoise d’IA DeepSeek, lancé plus tôt cette année, a fait sensation en rivalisant avec les performances des principaux modèles d’IA des grandes entreprises, mais à une fraction du coût et de la puissance de calcul. Cela a entraîné des accusations selon lesquelles DeepSeek a utilisé la distillation des connaissances, une technique qui pourrait impliquer un accès non autorisé au modèle o1 d’OpenAI. Cependant, la distillation des connaissances est une technique d’IA bien établie, datant d’un article de Google de 2015. Elle consiste à transférer les connaissances d’un modèle « enseignant » plus grand vers un modèle « étudiant » plus petit, réduisant ainsi considérablement les coûts et la taille avec une perte de performance minime. Cette méthode est devenue omniprésente, stimulant les améliorations de modèles tels que BERT, et continue de montrer un potentiel immense dans diverses applications de l’IA. La controverse souligne la puissance et la nature établie de cette technique, et non sa nouveauté.