Modèle LLM inférieur à 100 Mo désormais installable via pip : présentation de llm-smollm2

2025-02-07

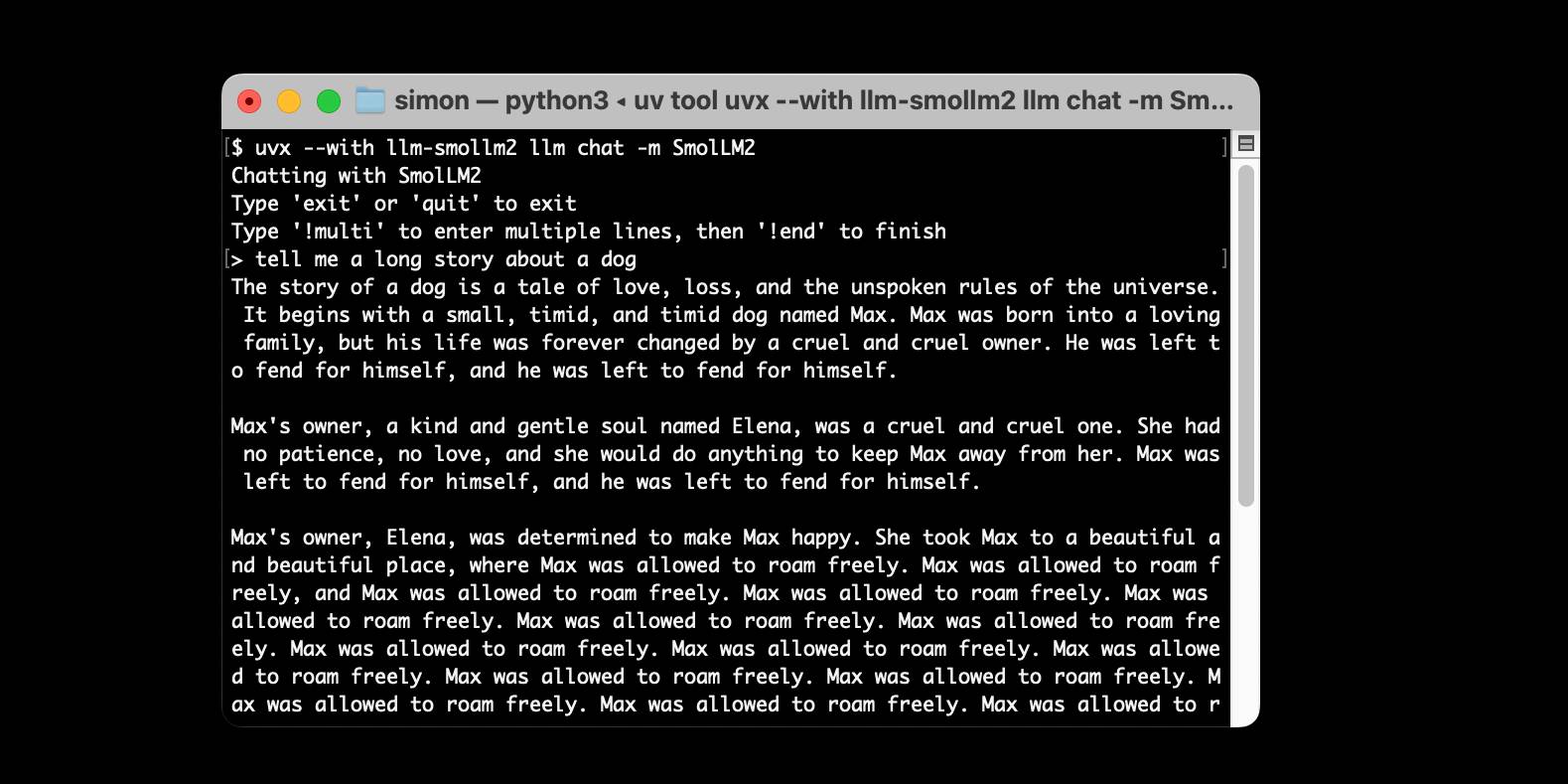

Un nouveau plugin, llm-smollm2, intègre un modèle LLM SmolLM2-135M-Instruct quantifié de moins de 100 Mo, le rendant installable via pip. L'auteur détaille le processus de création, de la recherche d'un modèle approprié de moins de 100 Mo (limité par les restrictions de taille de PyPI) à la suppression des journaux détaillés de llama-cpp-python et à l'empaquetage pour PyPI. Bien que les capacités du modèle soient limitées, il est présenté comme un outil d'apprentissage précieux pour comprendre la technologie LLM.

Développement

Quantification de modèle