Le Grand Hype des LLMs : Benchmarks vs. Réalité

2025-04-06

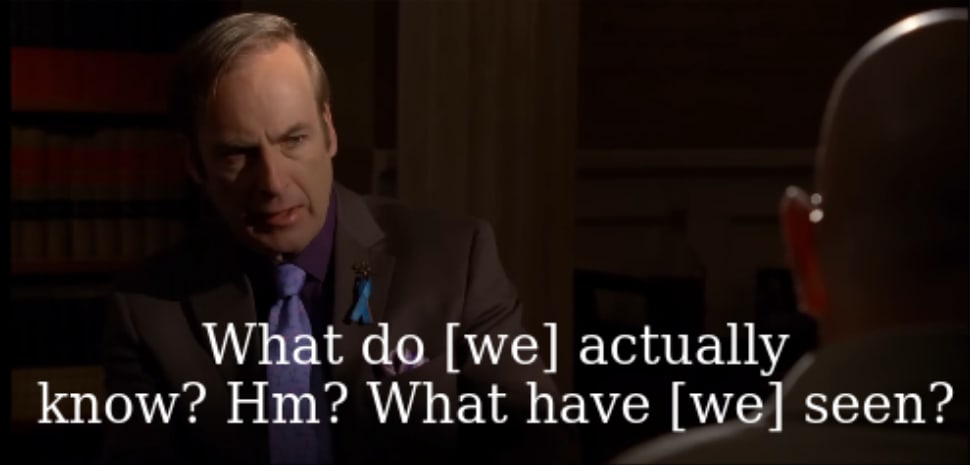

Une startup utilisant des modèles d'IA pour l'analyse de sécurité de code a constaté des améliorations pratiques limitées malgré l'augmentation des scores de référence depuis juin 2024. L'auteur soutient que les progrès des grands modèles de langage ne se traduisent pas par une utilité économique ou une généralisation, contredisant les affirmations publiques. Cela soulève des inquiétudes quant aux méthodes d'évaluation des modèles d'IA et à l'exagération possible des capacités par les laboratoires d'IA. L'auteur préconise de se concentrer sur les performances des applications réelles plutôt que sur les scores de référence et souligne la nécessité d'une évaluation robuste avant le déploiement de l'IA dans des contextes sociaux.