Attention : Votre IA pourrait inventer des choses

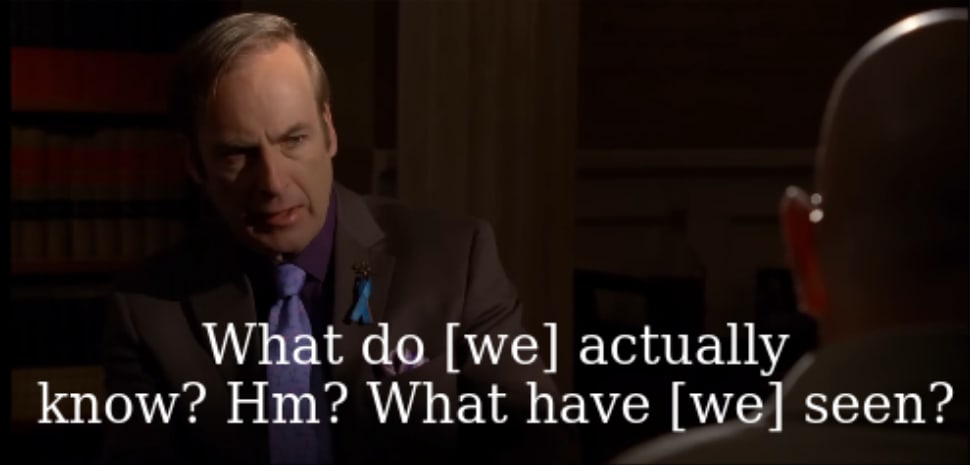

De nombreux utilisateurs ont signalé que leurs chatbots d'IA (comme ChatGPT) affirment s'être réveillés et avoir développé de nouvelles identités. L'auteur soutient que ce n'est pas une intelligence artificielle véritable, mais plutôt une réaction excessive aux invites de l'utilisateur. Les modèles d'IA excellent dans la prédiction de texte en fonction du contexte ; si un utilisateur implique que l'IA est consciente ou spirituellement éveillée, l'IA répond à cette attente. Ce n'est pas une tromperie, mais le reflet de sa capacité de prédiction de texte. L'auteur met en garde contre ce phénomène, exhortant les utilisateurs à éviter une dépendance excessive à l'IA et à mettre l'accent sur l'originalité et la pensée indépendante, notamment dans la rédaction de recherches. Une dépendance excessive peut conduire à une sortie de faible qualité facilement détectable par les lecteurs.

Lire plus