L'hypothèse de la représentation platonicienne : vers une inversion universelle des plongements et la communication avec les baleines

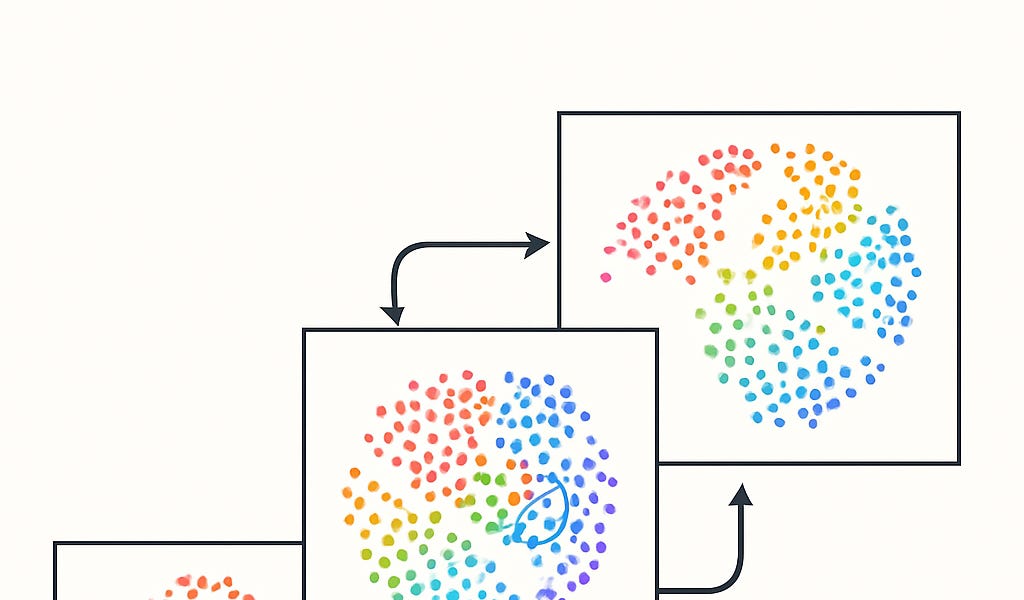

Des chercheurs ont découvert que les grands modèles de langage convergent vers un espace de représentation sous-jacent partagé à mesure qu'ils grandissent, un phénomène appelé « hypothèse de la représentation platonicienne ». Cela suggère que différents modèles apprennent les mêmes caractéristiques, quelle que soit l'architecture. L'article utilise le jeu « Mussolini ou pain » comme analogie pour expliquer cette représentation partagée et le soutient davantage par la théorie de la compression et la capacité de généralisation du modèle. De manière critique, sur la base de cette hypothèse, les chercheurs ont développé vec2vec, une méthode de conversion non supervisée entre les espaces d'intégration de différents modèles, atteignant une inversion d'intégration de texte de haute précision. Les applications futures pourraient inclure le décodage de textes anciens (comme le linéaire A) ou la traduction du langage des baleines, ouvrant de nouvelles possibilités pour la compréhension interlinguistique et l'avancement de l'IA.

Lire plus