GATE : Un modèle d’évaluation intégrée de l’impact économique de l’IA

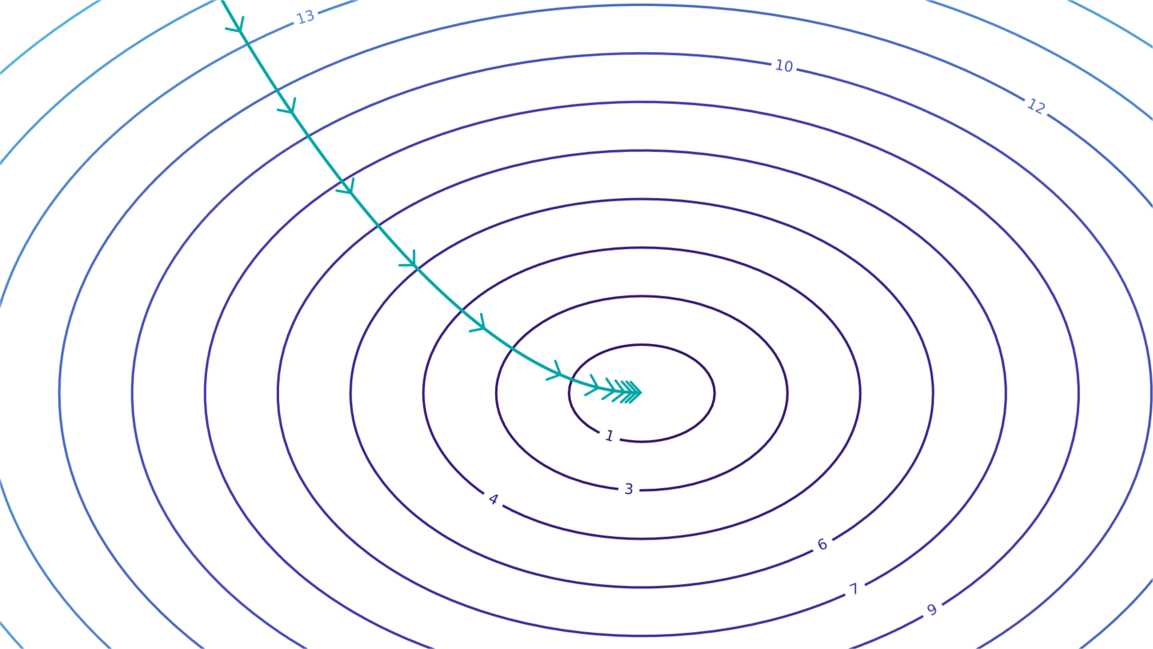

Epoch AI présente GATE, un modèle d’évaluation intégrée explorant l’impact économique de l’IA. Le modèle se concentre sur une boucle de rétroaction d’automatisation : l’investissement alimente la puissance de calcul, menant à des systèmes d’IA plus performants qui automatisent les tâches, augmentent la production et alimentent davantage le développement de l’IA. Un espace de jeu interactif permet aux utilisateurs de modifier les paramètres et d’observer le comportement du modèle dans divers scénarios. Les prédictions ne sont pas des prévisions d’Epoch AI, mais des prédictions conditionnelles, basées sur des hypothèses, principalement utiles pour analyser la dynamique qualitative de l’automatisation de l’IA.

Lire plus