Le regard pragmatique d'un data scientist senior sur l'IA générative

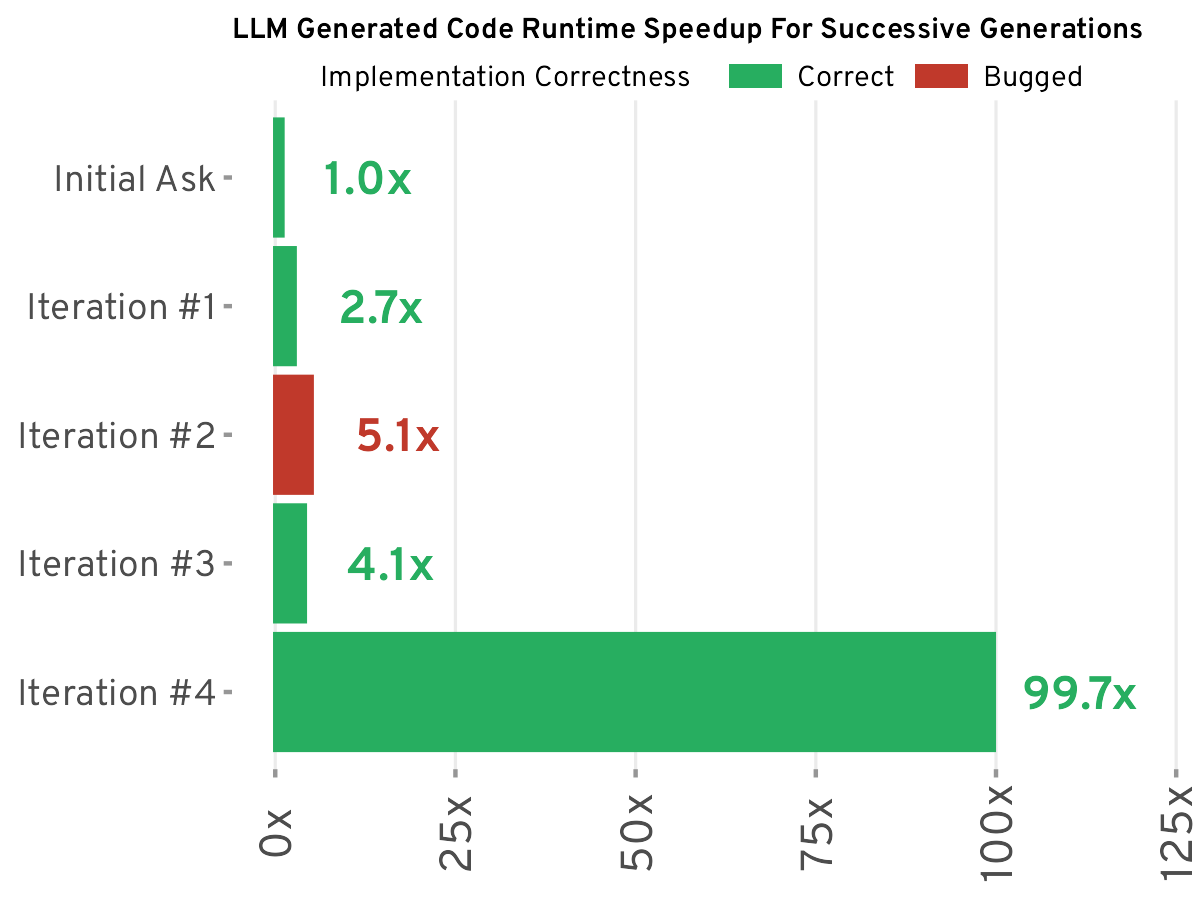

Un data scientist senior de BuzzFeed partage son approche pragmatique de l'utilisation des grands modèles de langage (LLM). Il ne considère pas les LLM comme une solution miracle, mais plutôt comme un outil pour améliorer l'efficacité, soulignant l'importance de l'ingénierie des invites. L'article détaille son utilisation réussie des LLM pour des tâches telles que la catégorisation des données, la synthèse de texte et la génération de code, tout en reconnaissant leurs limites, notamment dans les scénarios complexes de science des données où la précision et l'efficacité peuvent être compromises. Il soutient que les LLM ne sont pas une panacée, mais qu'utilisés avec discernement, ils peuvent augmenter significativement la productivité. La clé réside dans le choix de l'outil adapté à la tâche.

Lire plus