Six façons d'apprivoiser la bête : atténuation des échecs de contexte dans les LLM

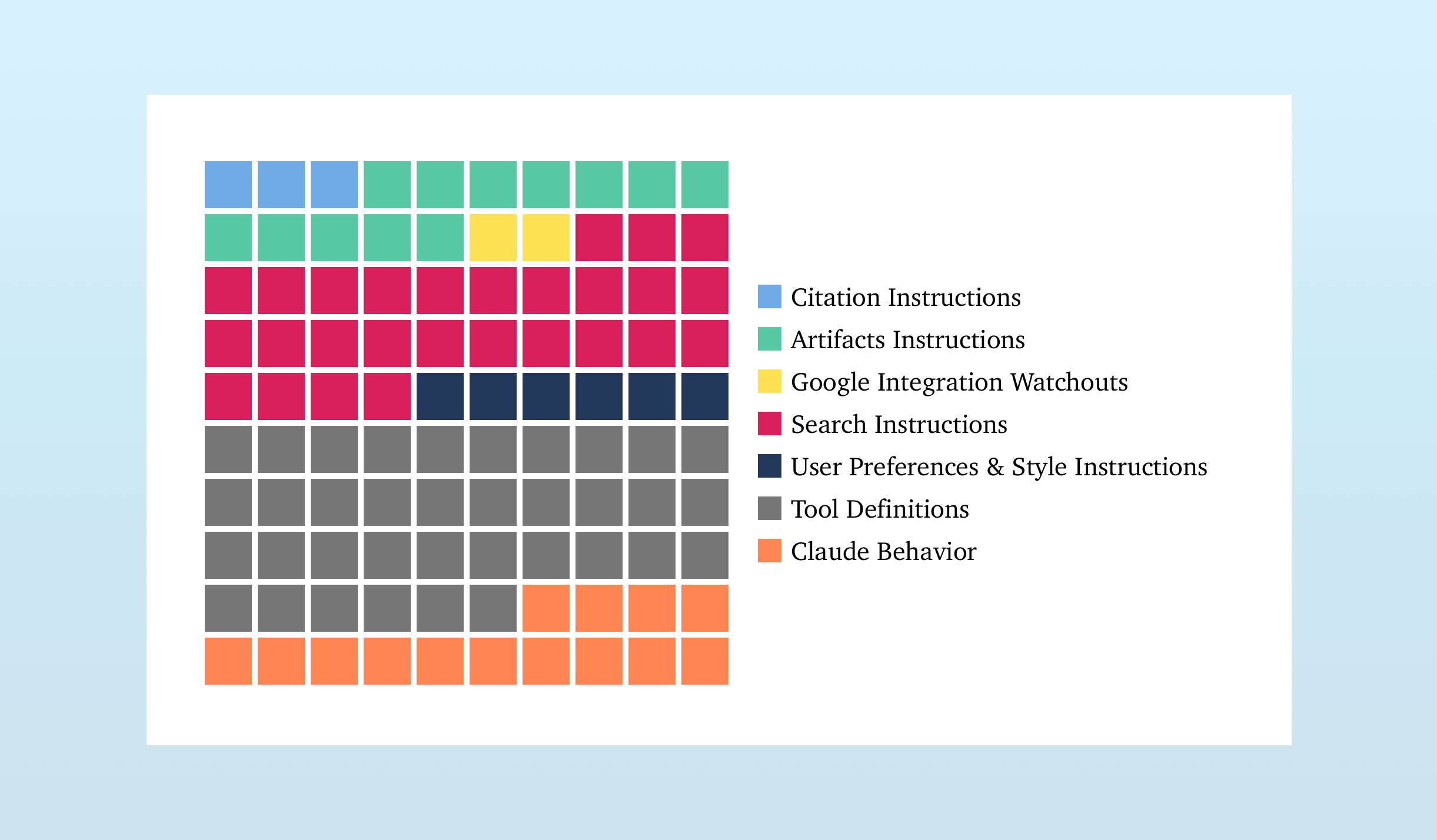

Les grands modèles de langage (LLM) disposent de fenêtres de contexte toujours plus grandes, mais un contexte excessif peut nuire aux performances. Cet article détaille six stratégies d'atténuation : la génération augmentée par la récupération (RAG) pour l'ajout sélectif d'informations ; la configuration des outils pour choisir les outils pertinents ; la quarantaine de contexte pour isoler les contextes dans des threads séparés ; l'élagage du contexte pour supprimer les informations non pertinentes ; la synthèse du contexte pour condenser le contexte ; et la décharge du contexte pour stocker des informations en dehors du contexte du LLM. Des études montrent que ces méthodes améliorent considérablement la précision et l'efficacité du modèle, notamment lorsqu'il s'agit de gérer de nombreux outils ou des tâches complexes.

Lire plus