Le Secret de Word2Vec : Comparaison des méthodes traditionnelles et neuronales

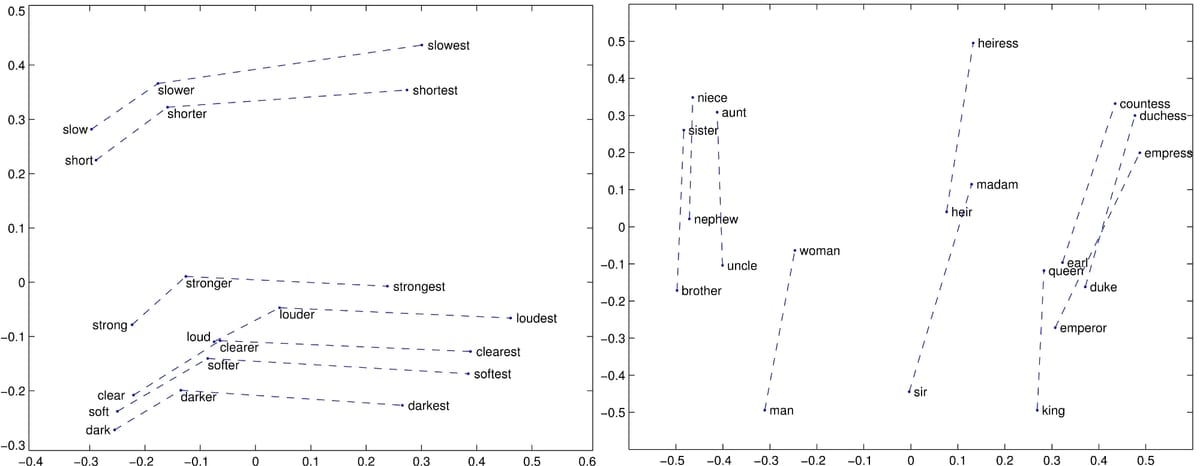

Cet article de blog explore les facteurs qui contribuent au succès de Word2Vec et son lien avec les modèles traditionnels d'embedding de mots. En comparant des modèles tels que GloVe, SVD, Skip-gram with Negative Sampling (SGNS) et PPMI, l'auteur révèle que l'optimisation des hyperparamètres est souvent plus importante que le choix de l'algorithme. La recherche montre que les modèles sémantiques distributionnels traditionnels (DSM), avec un prétraitement et un post-traitement appropriés, peuvent atteindre des performances comparables aux modèles de réseaux neuronaux. L'article souligne les avantages de la combinaison des méthodes traditionnelles et neuronales, offrant une nouvelle perspective sur l'apprentissage des embeddings de mots.

Lire plus