大規模言語モデルのファインチューニング:知識注入か破壊的書き換えか?

2025-06-11

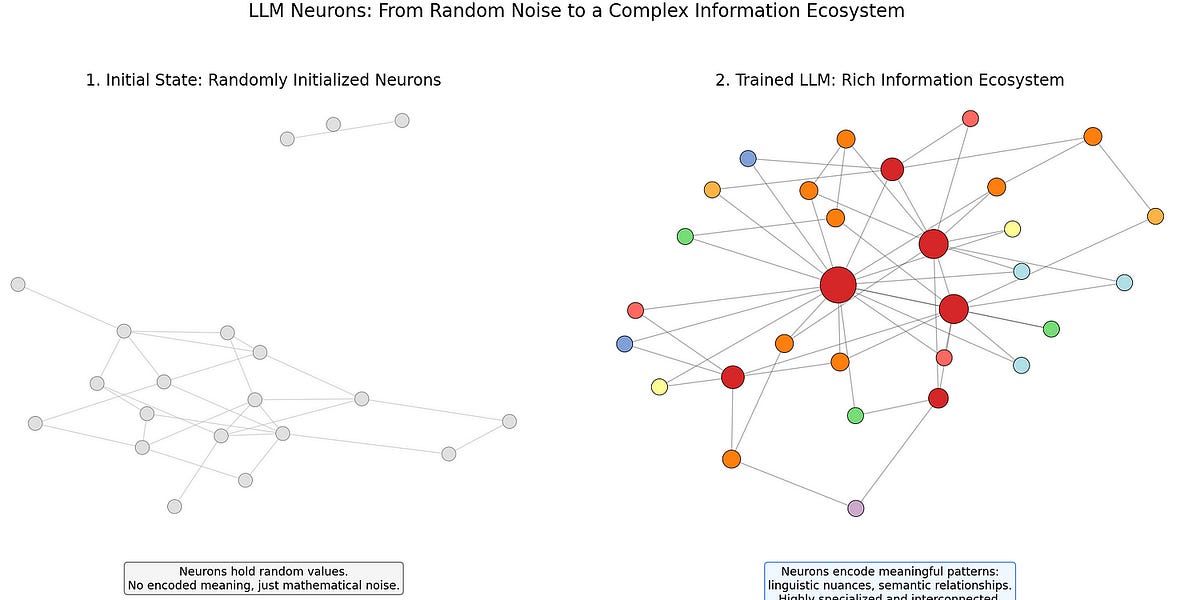

この記事は、大規模言語モデル(LLM)のファインチューニングの限界を示しています。著者は、高度なLLMの場合、ファインチューニングは単なる知識注入ではなく、既存の知識構造を破壊する可能性があると主張しています。この記事では、ニューラルネットワークの動作メカニズムを深く掘り下げ、ファインチューニングが既存のニューロン内の重要な情報の損失につながり、予期せぬ結果をもたらす可能性があることを説明しています。著者は、リトリーバル拡張生成(RAG)、アダプターモジュール、プロンプトエンジニアリングなどのモジュール型のアプローチを採用して、モデルの全体的なアーキテクチャを損なうことなく、より効果的に新しい知識を注入することを提唱しています。

AI

知識注入