ミニマルTransformerの解剖:1万パラメータでLLMの内部動作を明らかにする

2025-09-04

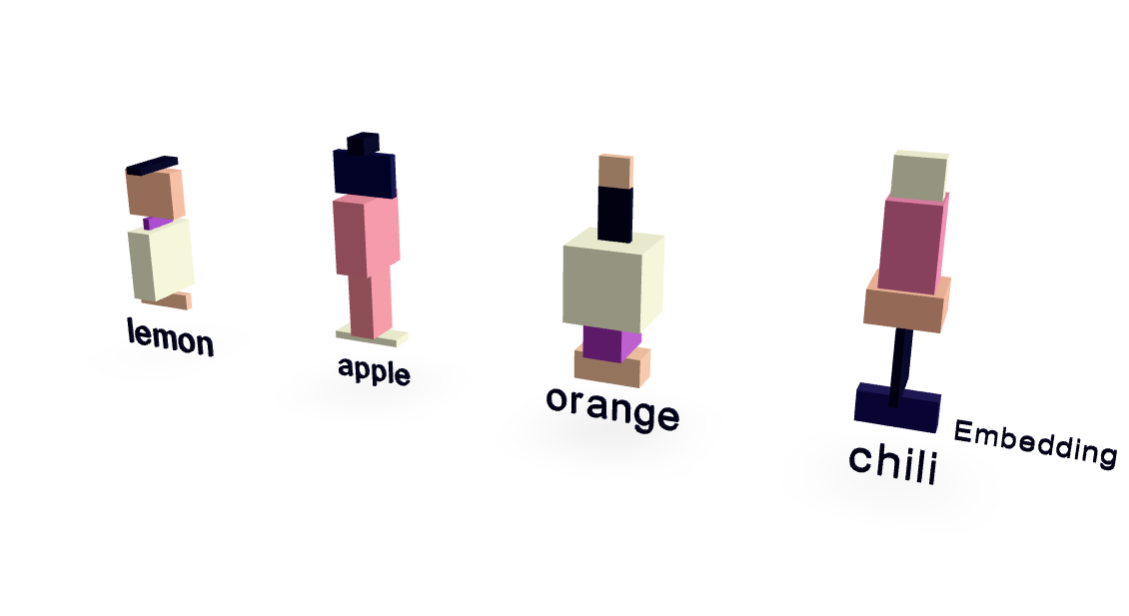

この論文では、わずか約1万パラメータの極めて簡素化されたTransformerモデルを紹介し、大規模言語モデル(LLM)の内部動作を明確に示しています。果物と味覚の関係に焦点を当てた最小限のデータセットを使用することで、驚くほど高い性能を達成しています。可視化により、単語埋め込みとアテンションメカニズムの機能が明らかになります。重要なことに、このモデルは単なる暗記を超えて一般化し、「辛いから好き」というプロンプトに対して「唐辛子」を正しく予測することで、LLM動作の中核となる原理を非常に分かりやすく示しています。

AI