DeepSeek v3:Transformerアーキテクチャの大きな改良

2025-01-28

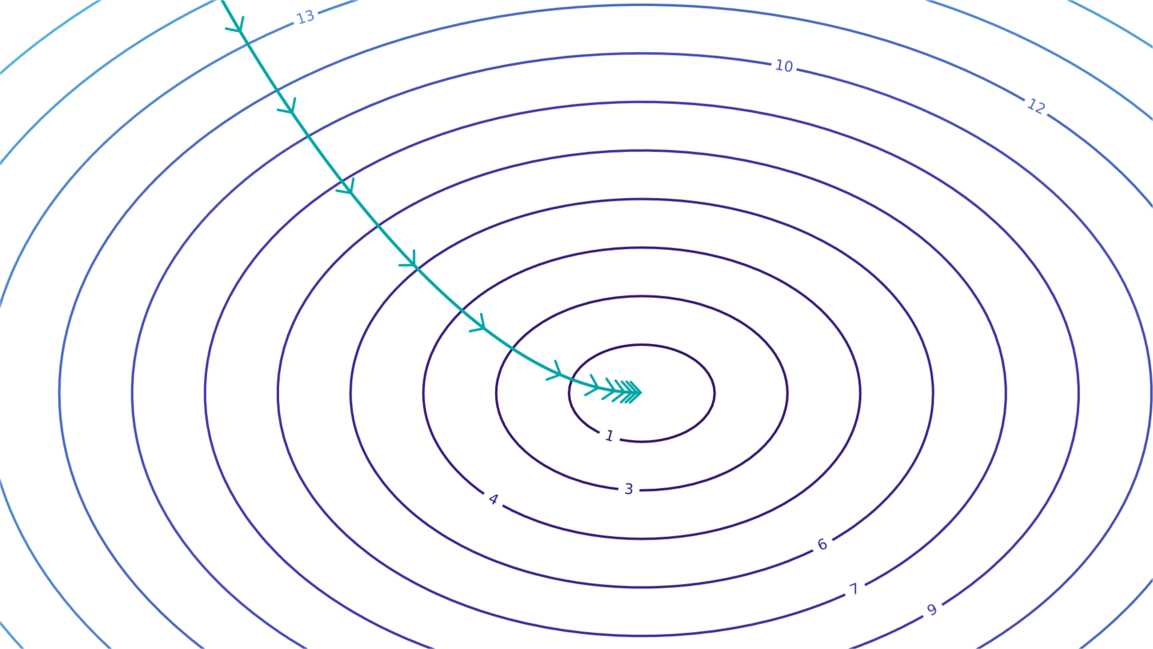

DeepSeek v3は、同等のモデルよりも大幅に少ない計算量で、ベンチマークにおいて最先端の性能を達成しています。これは、以下の重要なアーキテクチャ上の改良によるものです。多頭潜在的アテンション(MLA)メカニズムは、モデルの品質を犠牲にすることなく、KVキャッシュのサイズを大幅に削減します。改良された混合専門家(MoE)手法は、補助損失のない負荷バランスと共有専門家戦略によって、ルーティング崩壊の問題に対処します。そして、マルチトークンプレディクションは、トレーニング効率と推論速度を向上させます。これらの改良は、Transformerアーキテクチャに対するDeepSeekチームの深い理解を示しており、大規模言語モデルの発展の方向性を示しています。

(epoch.ai)

AI