DeepSeekのAIブレークスルー:CUDAをバイパスして10倍の効率を実現

2025-01-29

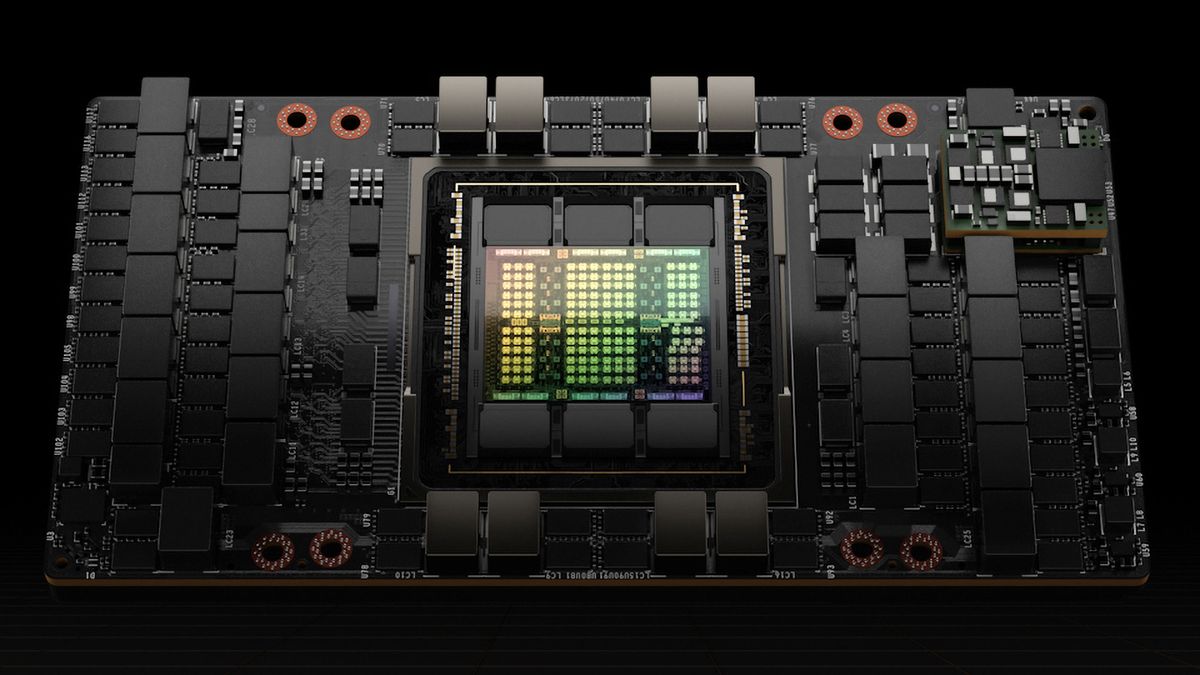

DeepSeekは、業界標準であるCUDAをバイパスし、NvidiaのPTXプログラミング言語を使用することで、AIモデルのトレーニング効率を10倍に向上させました。2048個のNvidia H800 GPUを使用して、わずか2ヶ月で6710億パラメーターのMoE言語モデルをトレーニングしました。このブレークスルーは、NvidiaのPTXに対する綿密な最適化、GPUリソースの再構成、高度なパイプラインアルゴリズムの実装によるものです。このアプローチは保守コストが高いものの、トレーニングコストの大幅な削減により市場に衝撃を与え、Nvidiaの時価総額の大幅な減少さえ引き起こしました。

AI

AIモデルトレーニング