LLM 0.26: Modelos de Linguagem Grandes Ganham Ferramentas de Terminal

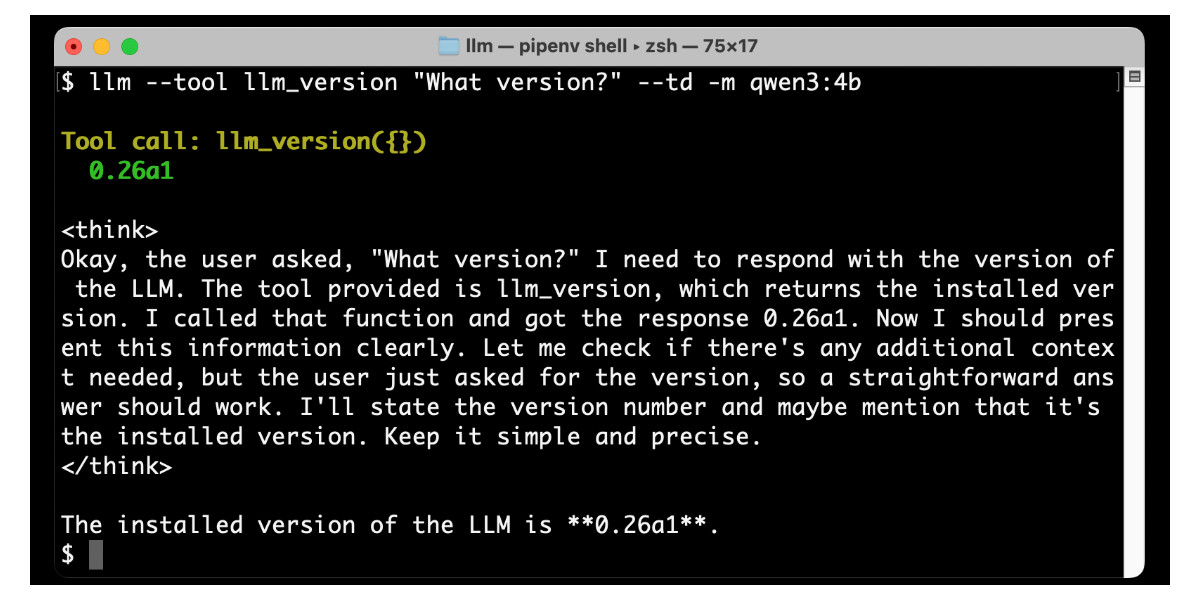

O LLM 0.26 foi lançado, trazendo o maior recurso desde o início do projeto: suporte a ferramentas. A CLI do LLM e a biblioteca Python agora permitem que você dê a LLMs do OpenAI, Anthropic, Gemini e modelos locais do Ollama acesso a qualquer ferramenta representável como uma função Python. O artigo detalha a instalação e o uso de plugins de ferramentas, a execução de ferramentas por meio da linha de comando ou da API Python e mostra exemplos com OpenAI, Anthropic, Gemini e até mesmo o pequeno modelo Qwen-3. Além das ferramentas integradas, plugins personalizados como simpleeval (para matemática), quickjs (para JavaScript) e sqlite (para consultas de banco de dados) são apresentados. Esse suporte a ferramentas aborda as fraquezas do LLM, como cálculos matemáticos, expandindo dramaticamente as capacidades e abrindo possibilidades para aplicativos de IA poderosos.