Além do BPE: O Futuro da Tokenização em Modelos de Linguagem Grandes

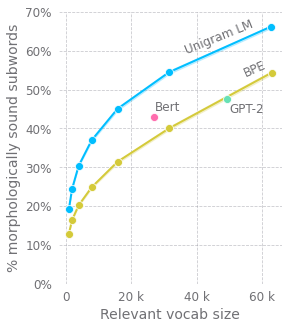

Este artigo explora melhorias nos métodos de tokenização em grandes modelos de linguagem pré-treinados. O autor questiona o método comumente usado de Codificação de Par de Bytes (BPE), destacando suas deficiências no tratamento de subpalavras no início e dentro das palavras. São sugeridas alternativas, como adicionar uma máscara de nova palavra. Além disso, o autor argumenta contra o uso de algoritmos de compressão para pré-processamento de entradas, defendendo a modelagem de linguagem em nível de caractere, traçando paralelos com Redes Neurais Recorrentes (RNNs) e modelos de atenção própria mais profundos. No entanto, a complexidade quadrática do mecanismo de atenção apresenta um desafio. O autor propõe uma abordagem baseada em estrutura de árvore, usando subsequências com janela e atenção hierárquica para reduzir a complexidade computacional enquanto captura melhor a estrutura da linguagem.