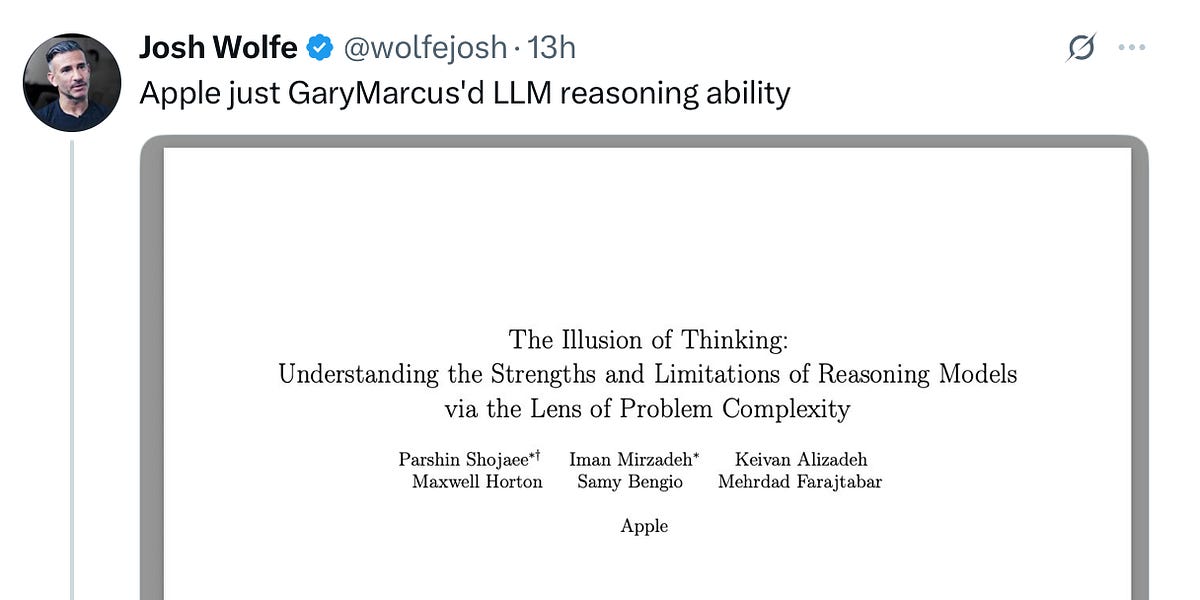

Artigo da Apple Desmascara LLMs: Torre de Hanói Revela Limitações

Um novo artigo da Apple causou ondas na comunidade de IA. O artigo demonstra que, mesmo a geração mais recente de "modelos de raciocínio", falha em resolver o clássico problema da Torre de Hanói de forma confiável, expondo uma falha crítica nas capacidades de raciocínio dos Modelos de Linguagem Grandes (LLMs). Isso se alinha com as críticas de longa data de pesquisadores como Gary Marcus e Subbarao Kambhampati, que destacaram as capacidades limitadas de generalização dos LLMs. O artigo mostra que, mesmo quando fornecido com o algoritmo de solução, os LLMs ainda falham em resolver o problema de forma eficaz, sugerindo que seu "processo de raciocínio" não é um raciocínio lógico genuíno. Isso indica que os LLMs não são um caminho direto para a Inteligência Artificial Geral (AGI), e suas aplicações precisam de consideração cuidadosa.