Informações desatualizadas em LLMs: como as probabilidades de tokens criam inconsistências lógicas

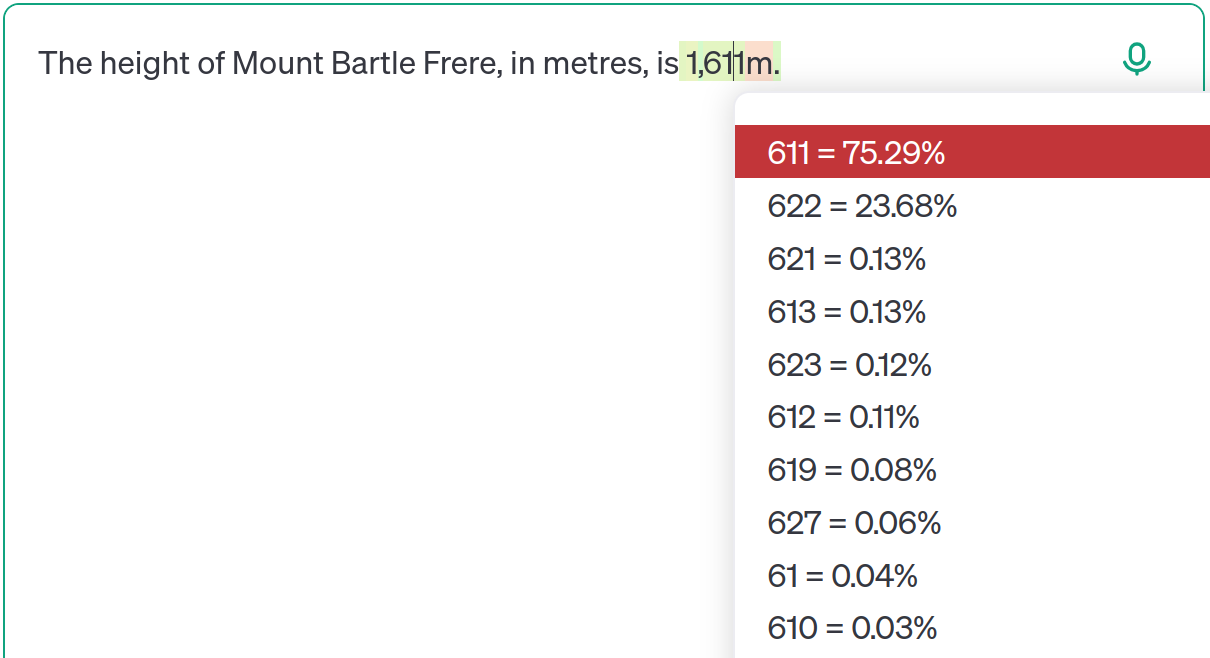

Modelos de linguagem grandes (LLMs) como o ChatGPT, treinados em conjuntos de dados massivos da internet, frequentemente enfrentam informações conflitantes ou desatualizadas. Este artigo usa a altura do Monte Bartle Frere como um estudo de caso, mostrando como os LLMs nem sempre priorizam as informações mais recentes. Em vez disso, eles fazem previsões com base em distribuições de probabilidade aprendidas de seus dados de treinamento. Mesmo modelos avançados como o GPT-4o podem produzir informações desatualizadas dependendo de variações sutis no prompt. Isso não é uma simples 'alucinação', mas uma consequência do modelo aprender múltiplas possibilidades e ajustar as probabilidades com base no contexto. O autor destaca a importância de entender as limitações dos LLMs, evitando a dependência excessiva e enfatizando a transparência.