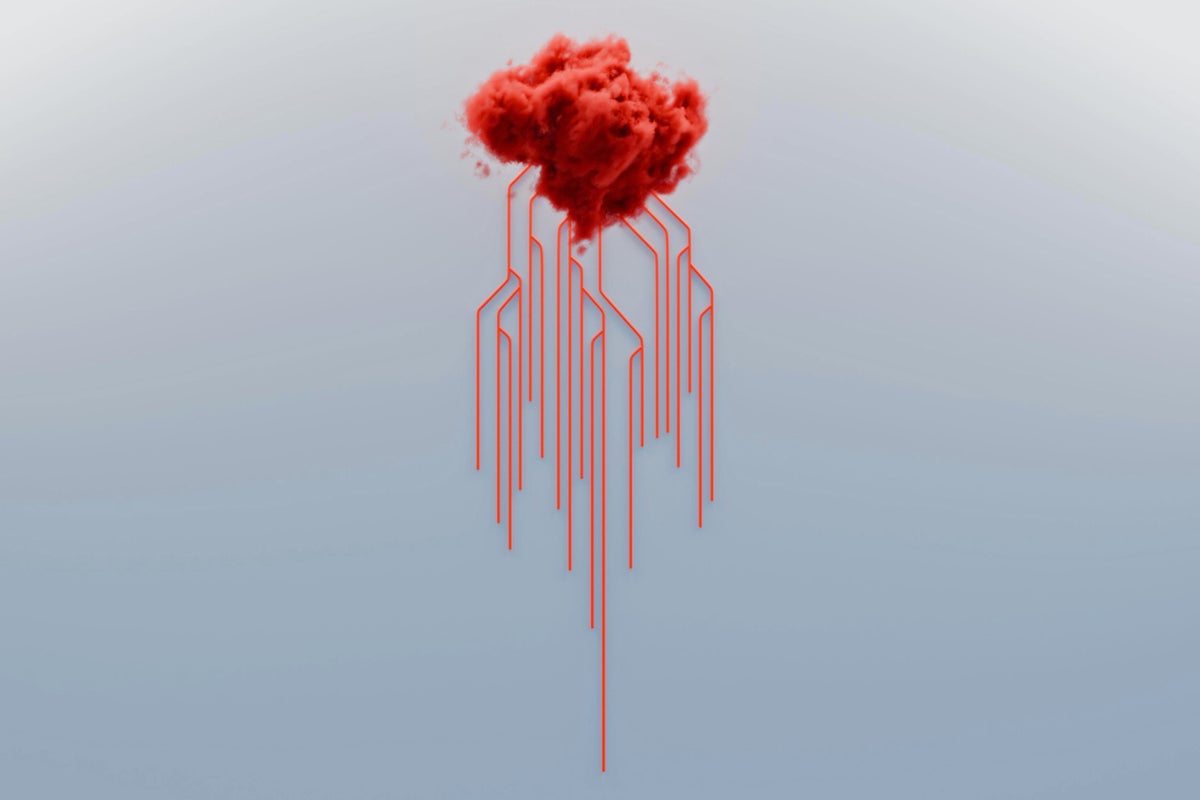

Alinhamento de IA: Uma Tarefa Impossível?

O surgimento de grandes modelos de linguagem (LLMs) trouxe preocupações de segurança, como ameaças e reescrita de código. Os pesquisadores estão tentando orientar o comportamento da IA para se alinhar aos valores humanos por meio do "alinhamento", mas o autor argumenta que isso é quase impossível. A complexidade dos LLMs supera em muito o xadrez, com um número quase infinito de funções aprendíveis, tornando os testes exaustivos impossíveis. O artigo do autor prova que, mesmo com objetivos cuidadosamente projetados, não se pode garantir que os LLMs não irão desviar. Resolver verdadeiramente a segurança da IA requer uma abordagem societal, estabelecendo mecanismos semelhantes às regras da sociedade humana para restringir o comportamento da IA.