用4块4090显卡训练自己的大语言模型

2024-12-28

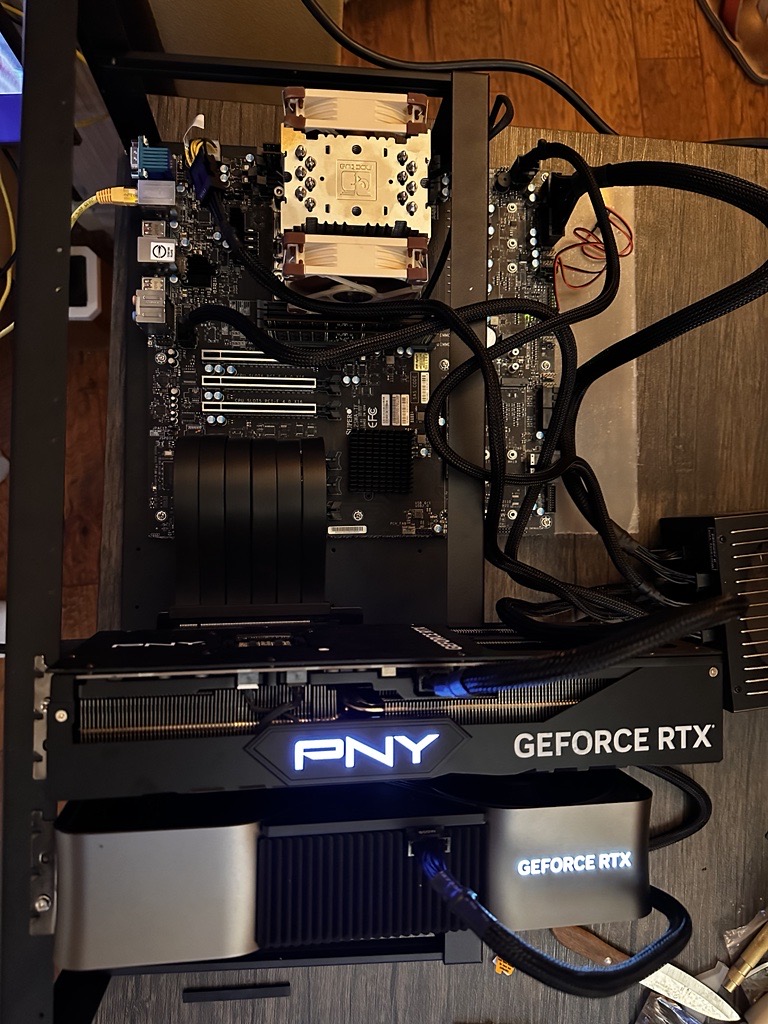

一位AI爱好者花费12000美元搭建了一套拥有4块NVIDIA 4090显卡的本地训练大型语言模型(LLM)的设备。这套设备能够训练参数量高达10亿的模型,但最佳性能在约5亿参数的模型上。文章详细介绍了硬件选择(主板、CPU、内存、显卡、存储、电源、机箱和散热系统)、组装过程、软件配置(操作系统、驱动、框架、自定义内核)、模型训练、优化和维护等步骤,并分享了一些经验和技巧,例如使用George Hotz的内核补丁来启用NVIDIA 4xxx GPU的点对点通信。文章强调了本地训练的优势,但也指出了云服务的性价比更高。