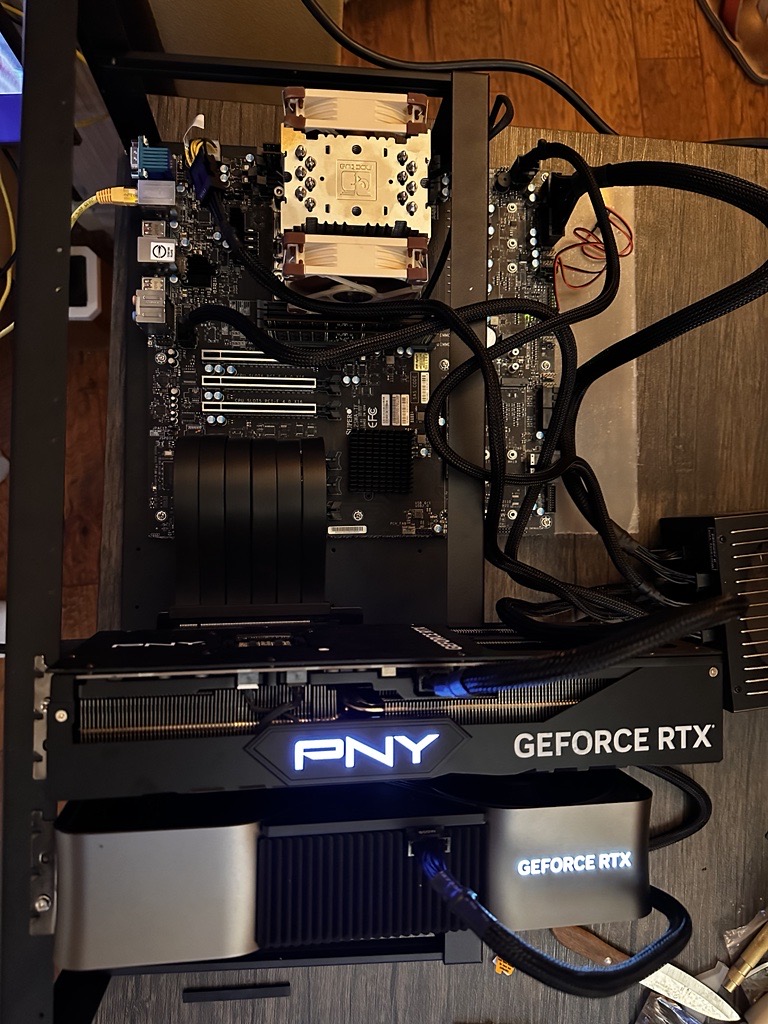

4 GPUs 4090: Entrenando tus propios LLMs localmente

Un entusiasta de IA construyó un equipo local para entrenar modelos de lenguaje grandes (LLMs) utilizando cuatro GPUs NVIDIA 4090, con un costo aproximado de $12,000 USD. Esta configuración puede entrenar modelos de hasta 1 billón de parámetros, aunque funciona de manera óptima con alrededor de 500 millones. El artículo detalla la selección de hardware (placa base, CPU, RAM, GPUs, almacenamiento, fuente de alimentación, caja, sistema de refrigeración), el proceso de ensamblaje, la configuración del software (SO, controladores, frameworks, kernel personalizado), el entrenamiento del modelo, la optimización y el mantenimiento. Los consejos incluyen el uso del parche de kernel de George Hotz para la comunicación P2P en GPUs 4xxx. Si bien destaca los beneficios del entrenamiento local, el autor reconoce la rentabilidad de las soluciones en la nube para algunas tareas.