Executando LLMs Localmente: Um Guia para Desenvolvedores

2024-12-29

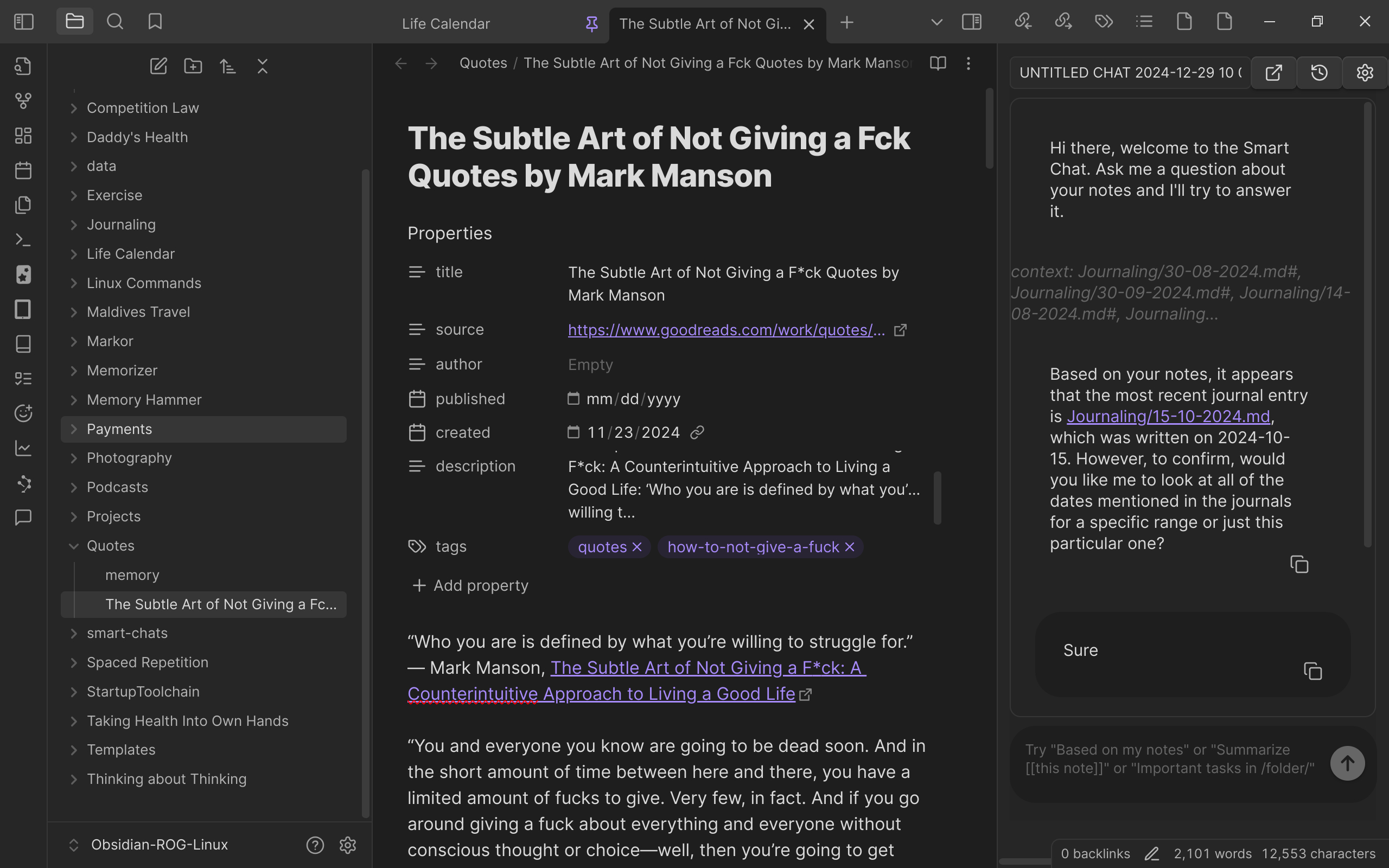

Um desenvolvedor compartilha sua experiência executando Modelos de Linguagem Grandes (LLMs) em um computador pessoal. Usando uma máquina de alta especificação (CPU i9, GPU 4090, 96 GB de RAM), juntamente com ferramentas de código aberto como Ollama e Open WebUI, eles executaram com sucesso vários LLMs para tarefas como conclusão de código e consulta de notas. O artigo detalha o hardware, software, modelos usados e métodos de atualização, destacando as vantagens de segurança de dados e baixa latência de executar LLMs localmente.