معلومات عتيقة مختبئة في نماذج اللغات الكبيرة: كيف تؤدي احتمالات الرموز إلى عدم الاتساق المنطقي

2025-01-12

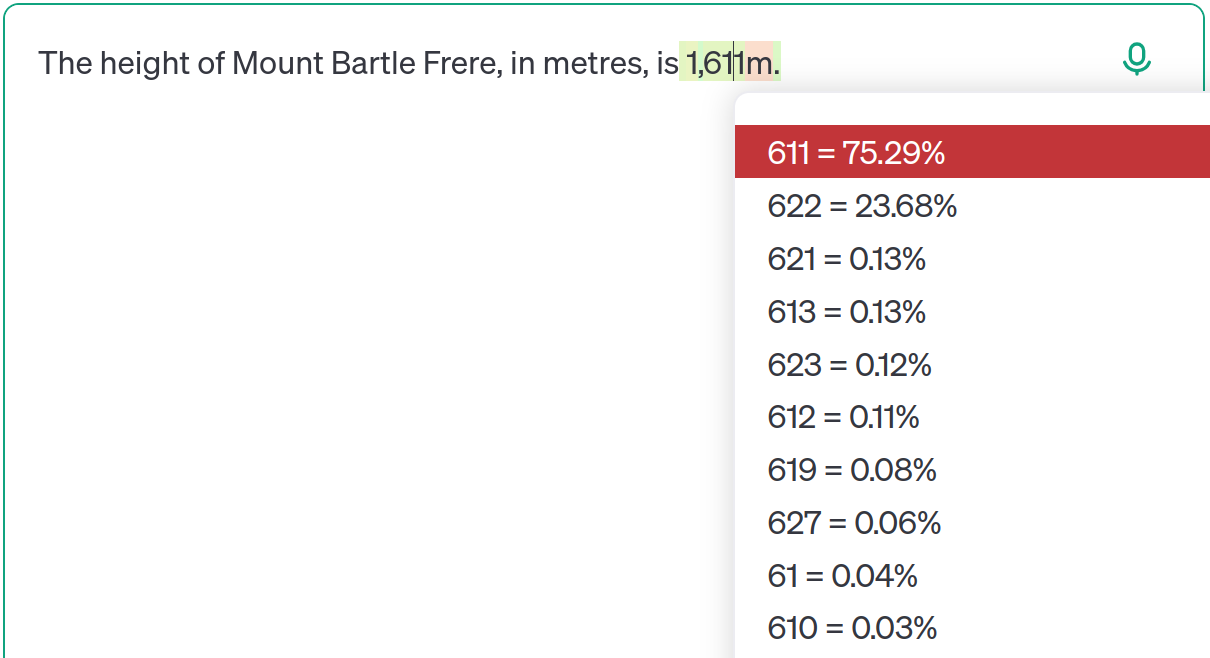

نماذج اللغات الكبيرة (LLMs) مثل ChatGPT، المدربة على مجموعات بيانات ضخمة من الإنترنت، غالبًا ما تواجه معلومات متضاربة أو عتيقة. تستخدم هذه المقالة ارتفاع جبل Bartle Frere كدراسة حالة، تُظهر كيف لا تعطي نماذج LLMs دائمًا الأولوية لأحدث المعلومات. بدلاً من ذلك، فإنها تقوم بالتنبؤات بناءً على توزيعات الاحتمالات التي تم تعلمها من بيانات التدريب الخاصة بها. حتى النماذج المتقدمة مثل GPT-4o قد تُخرج معلومات عتيقة بناءً على اختلافات دقيقة في الإشارة. هذا ليس مجرد "هلوسة"، بل نتيجة لتعلم النموذج إمكانيات متعددة وضبط الاحتمالات بناءً على السياق. يبرز الكاتب أهمية فهم حدود LLMs، وتجنب الاعتماد المفرط، والتشديد على الشفافية.