LLMに潜む古い情報:トークンの確率が論理的な矛盾を生み出す仕組み

2025-01-12

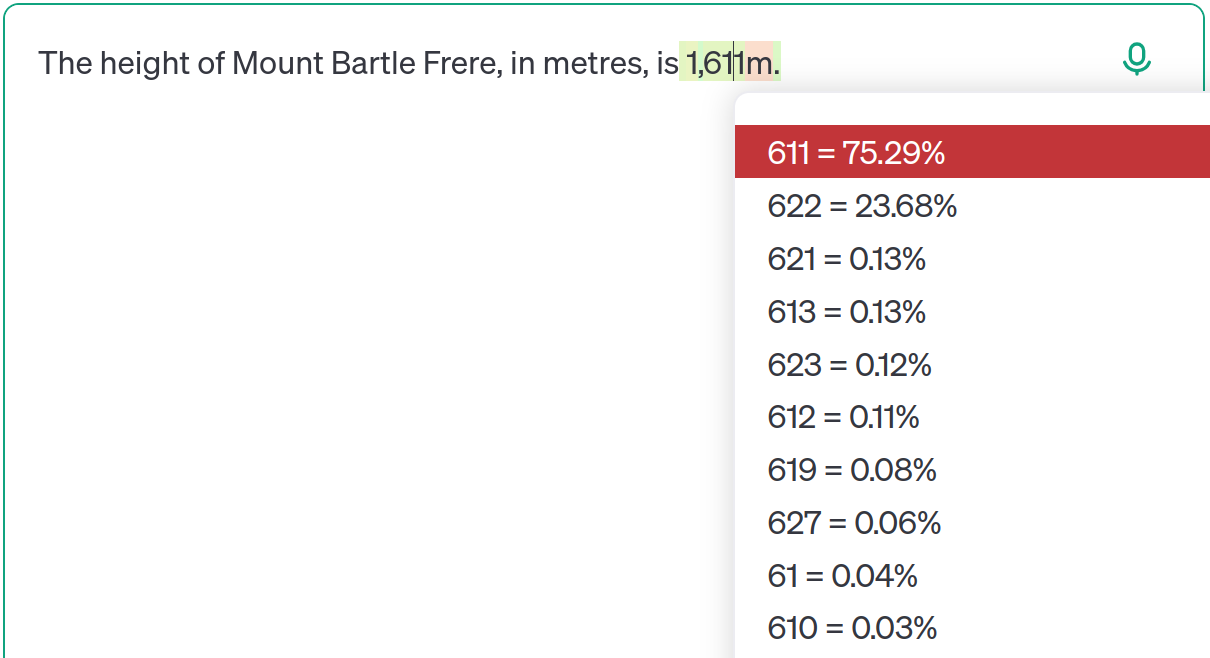

インターネット上の膨大なデータで訓練された、ChatGPTのような大規模言語モデル(LLM)は、しばしば矛盾したり時代遅れになった情報と格闘します。この記事では、バートルフレール山の高さをケーススタディとして使用し、LLMが常に最新の情報を優先するわけではないことを示しています。代わりに、LLMは、トレーニングデータから学習した確率分布に基づいて予測を行います。GPT-4oのような高度なモデルでさえ、微妙なプロンプトの変更によって古い情報を出力する可能性があります。これは単なる「幻覚」ではなく、モデルが複数の可能性を学習し、コンテキストに基づいて確率を調整する結果です。著者は、LLMの限界を理解し、過度の依存を避け、透明性を重視することの重要性を強調しています。