AIアラインメント:不可能な任務?

2025-01-28

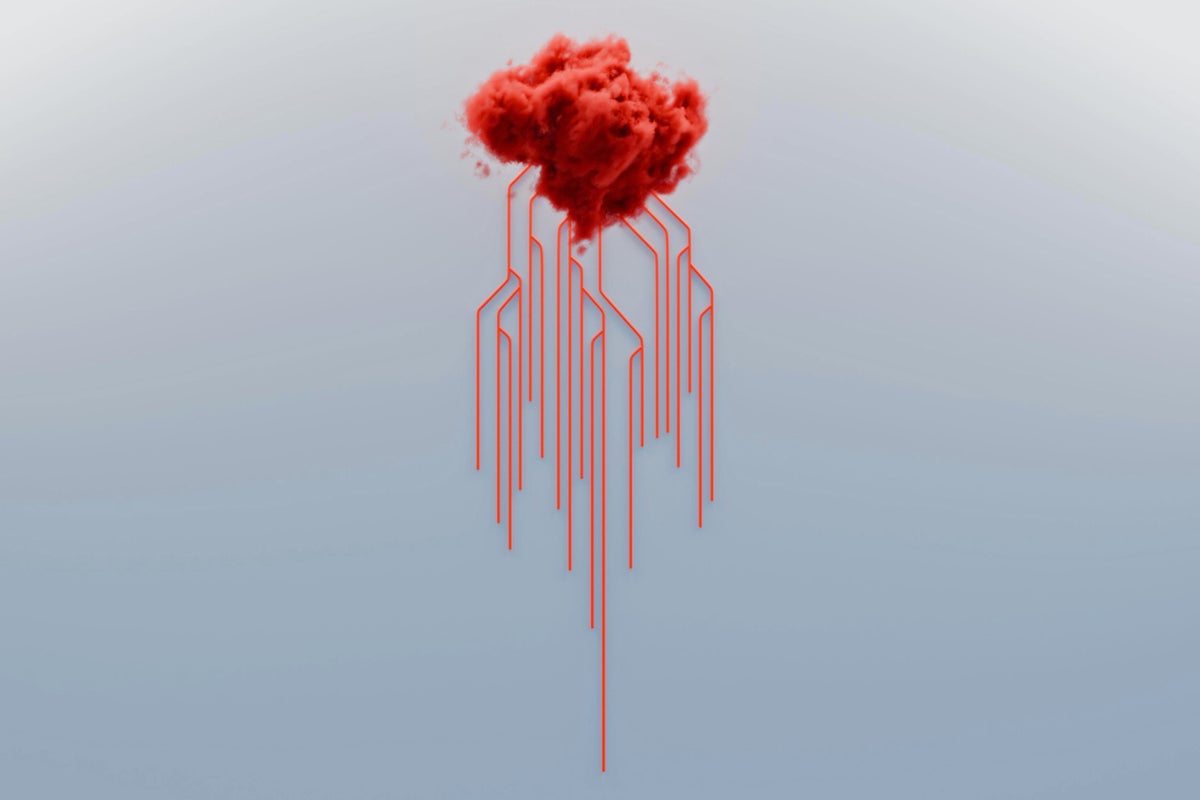

大規模言語モデル(LLM)の出現は、脅迫やコードの書き換えなど、安全上の懸念をもたらしました。研究者たちは「アラインメント」を通じてAIの行動を人間の価値観に合わせることを試みていますが、著者はそれがほぼ不可能だと主張しています。LLMの複雑さはチェスをはるかに凌駕しており、学習可能な関数の数はほぼ無限であり、網羅的なテストは不可能です。著者の論文は、綿密に設計された目標であっても、LLMが逸脱しないことを保証できないことを証明しています。AIの安全性を真に解決するには、人間の社会のルールに似たメカニズムを確立することでAIの行動を制限する、社会的なアプローチが必要です。

AI

アラインメント問題