Desenvolvimento de IA da DeepSeek Ignora CUDA e Alcança Eficiência 10x

2025-01-29

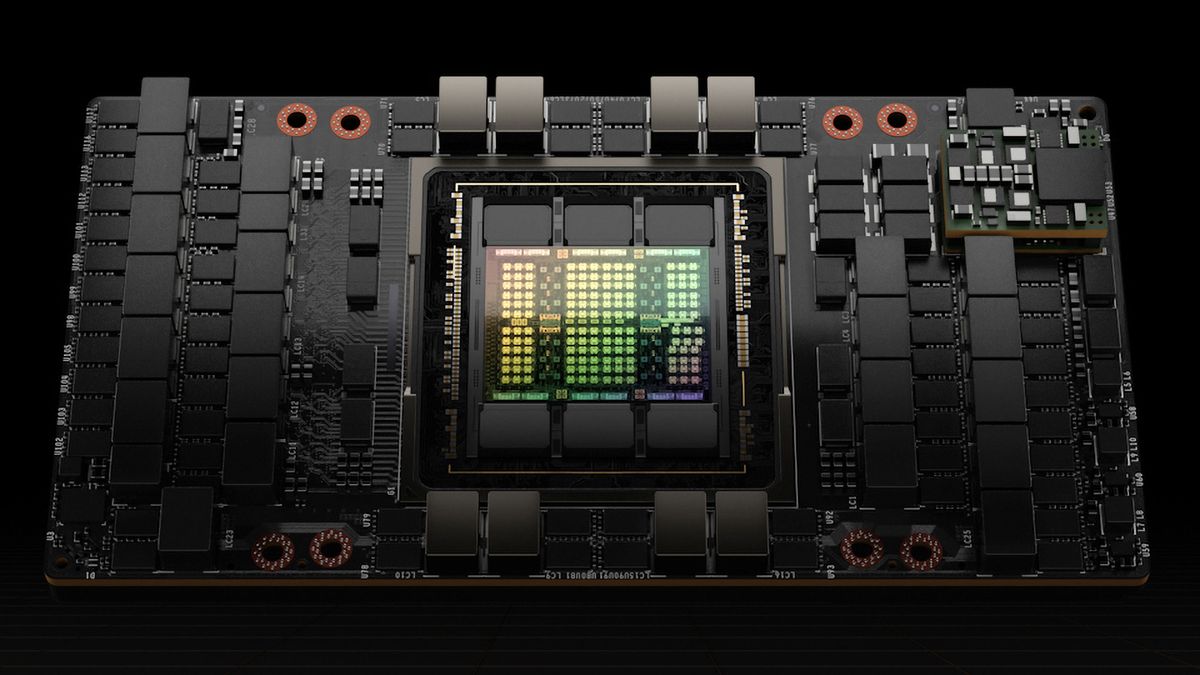

A DeepSeek alcançou um aumento de 10 vezes na eficiência do treinamento de modelos de IA, ignorando o CUDA padrão do setor e utilizando a linguagem de programação PTX da Nvidia. Usando 2.048 GPUs Nvidia H800, eles treinaram um modelo de linguagem MoE com 671 bilhões de parâmetros em apenas dois meses. Essa inovação surgiu de otimizações meticulosas do PTX da Nvidia, incluindo a reconfiguração de recursos de GPU e a implementação de algoritmos avançados de pipeline. Embora essa abordagem tenha altos custos de manutenção, a redução drástica nos custos de treinamento causou ondas de choque no mercado, levando até mesmo a uma queda significativa na capitalização de mercado da Nvidia.