シニアデータサイエンティストによる生成AIへの実用的なアプローチ

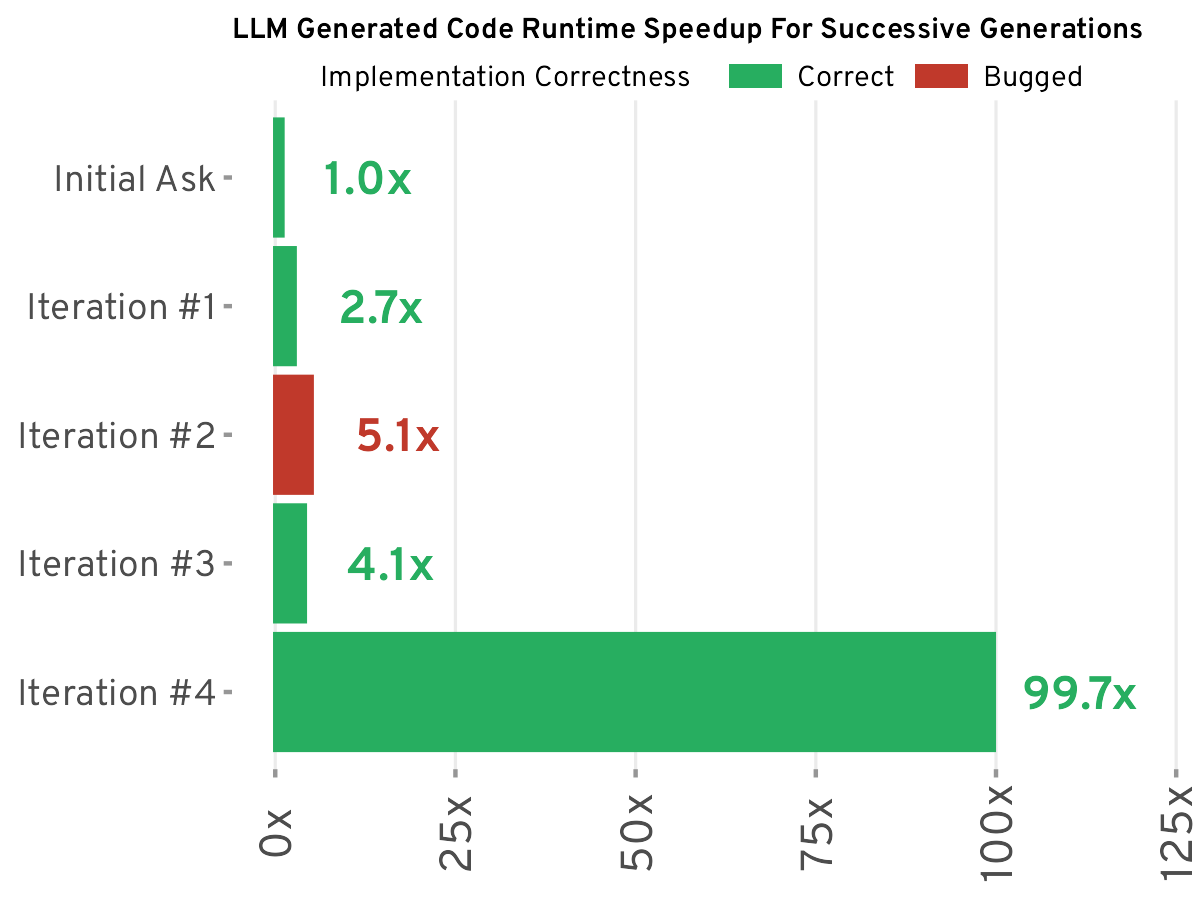

BuzzFeedのシニアデータサイエンティストが、大規模言語モデル(LLM)の実用的な使用方法を共有しています。LLMを万能な解決策ではなく、効率性を高めるためのツールと捉え、プロンプトエンジニアリングの重要性を強調しています。この記事では、データ分類、テキスト要約、コード生成などのタスクでLLMをどのように成功裏に使用したかについて詳しく説明し、特に複雑なデータサイエンスシナリオでは精度と効率が低下する可能性があるなど、LLMの限界についても認めています。LLMは万能薬ではないものの、賢く使用すれば生産性を大幅に向上させることができると主張しています。重要なのは、仕事に適したツールを選択することです。

続きを読む