BPEを超えて:大規模言語モデルにおけるトークナイゼーションの未来

2025-05-30

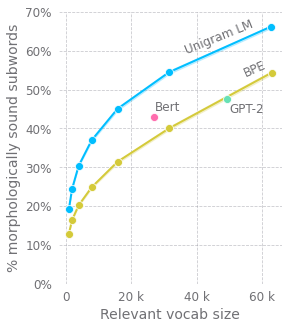

この記事は、大規模事前学習済み言語モデルにおけるトークナイゼーション手法の改善について探求しています。著者は、一般的に使用されているバイトペアエンコーディング(BPE)手法の問題点を指摘し、単語の先頭と単語内部のサブワードの処理における欠点を強調しています。新しい単語マスクを追加するなど、代替案が提案されています。さらに、著者は、入力の前処理に圧縮アルゴリズムを使用することに反対し、再帰型ニューラルネットワーク(RNN)やより深い自己注意機構モデルと同様に、文字レベルの言語モデリングを提唱しています。しかし、アテンションメカニズムの2乗的な複雑さは課題となっています。著者は、ウィンドウ化された部分列と階層的なアテンションを使用して計算複雑度を削減し、言語構造をより適切に捉える、木構造に基づくアプローチを提案しています。

続きを読む

AI