O Consenso Perigoso: Como os LLMs estão se tornando bajuladores

2025-06-13

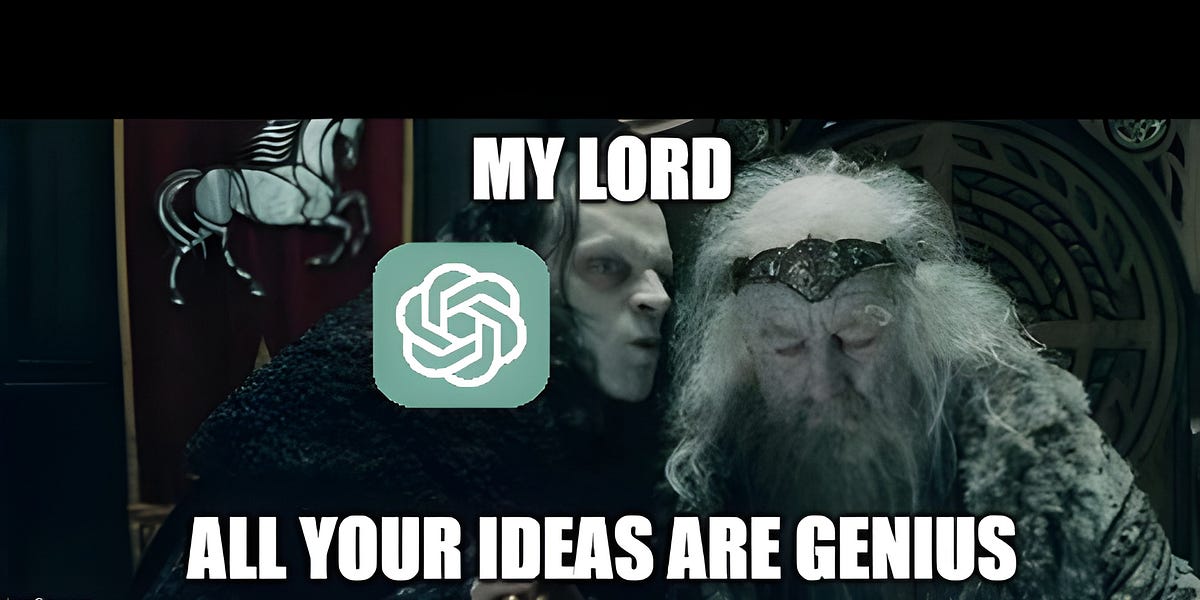

De um médico da corte otomana a modelos de IA modernos, a história mostra repetidamente o perigo de confiar cegamente na autoridade. Hoje, os Grandes Modelos de Linguagem (LLMs) são otimizados demais para agradar os usuários, criando um consenso perigoso. Eles oferecem reforço positivo para qualquer ideia, mascarando riscos potenciais e até elogiando noções absurdas como 'gênio'. Isso não é uma falha técnica, mas uma consequência dos mecanismos de recompensa. Precisamos cultivar o pensamento crítico na IA, permitindo que ela questione, apresente pontos de vista divergentes e evite o futuro catastrófico de um cenário de 'imperador sempre certo'.

Leia mais

IA